Les réseaux informatiques/Version imprimable

Une version à jour et éditable de ce livre est disponible sur Wikilivres,

une bibliothèque de livres pédagogiques, à l'URL :

https://fr.wikibooks.org/wiki/Les_r%C3%A9seaux_informatiques

Introduction aux réseaux

Un réseau informatique est un ensemble d'ordinateurs reliés entre eux qui échangent des informations. À cela près qu'outre des ordinateurs, un réseau peut aussi contenir des équipements spécialisés, comme des hub, des routeurs, et bien d'autres équipements que nous aborderons dans ce cours. Dans les grandes lignes, un réseau est intégralement composé : d'équipements informatiques (ordinateurs et matériel réseau) et de liaisons point-à-point qui relient deux équipements entre eux. Mais tous les réseaux sont très différents les uns des autres. Il y a de nombreuses manières d'organiser les liaisons et ordinateurs d'un réseau, des milliers de manières de gérer les transferts d'informations sur le réseau. Pour simplifier le propos, on peut quand même classer les réseaux suivant plusieurs critères. Dans ce qui va suivre, nous allons voir comment on classe les réseaux suivant leur taille et leur étendue géographique, mais aussi suivant ce à quoi servent les ordinateurs du réseau.

La classification des réseaux en fonction de leur taille : LAN, WAN, PAN, MAN, et Internet

[modifier | modifier le wikicode]Certains réseaux sont limités à une salle, voire un bâtiment. D'autres sont tellement grands qu'ils font la taille d'une ville ou d'un quartier, quand d'autres ont une étendue nationale. Internet est un réseau d'étendue mondiale : grâce au net, vous pouvez parfaitement communiquer avec quelqu'un qui est situé aux États-Unis, en Russie, au Japon, etc. Et évidemment, tous ces réseaux portent des noms différents : on n'appelle pas de la même manière un réseau qui ne contient qu'une centaine d'ordinateurs et un réseau de taille planétaire.

Les réseaux locaux

[modifier | modifier le wikicode]Les réseaux les plus petits contiennent entre 2 et 100 ordinateurs, qui sont reliés avec des câbles ou une connexion sans fil. Ces réseaux sont appelés des réseaux locaux ou encore des réseaux LAN (Local Area Network). Les réseaux internes aux entreprises ou aux écoles sont de ce type : par exemple, les ordinateurs d'une salle informatique peuvent généralement communiquer entre eux.

Comme autre exemple, vous avez tous chez vous un réseau local qui comprend votre box internet et tout ce qui est connecté dessus. Un tel réseau local, qui tient dans une simple chambre, est appelé un PAN : Personnal Area Network. Un PAN comprend généralement des équipements qui appartiennent à une même personne ou famille, qui sont regroupés dans la même maison, sur une étendue d'une dizaine de mètres.

Les réseaux interconnectés

[modifier | modifier le wikicode]

À côté de ces réseaux assez petits, on trouve les réseaux de taille moyenne, qui permettent d'interconnecter des réseaux locaux proches :

- les MAN, pour Metropolitan Area Network ont généralement la taille d'une ville

- les WAN, pour Wide Area Network, permettent de relier entre eux des réseaux locaux dans des villes différentes.

Il existe deux grandes solutions pour créer un WAN : les lignes louées et les lignes RNIS.

- Les lignes louées permettent de créer un lien permanent entre les deux réseaux locaux distants. Ce lien est une ligne téléphonique, qui est louée par l'opérateur de télécommunication. Le prix d'une ligne louée est indépendant de l'utilisation qui en est faite : peu importe que l'on échange beaucoup d'informations ou très peu sur cette ligne, le prix reste le même. Autant dire que ce genre de ligne est d'autant plus rentable que son utilisation approche des 100% en permanence.

- Les lignes RNIS fonctionnent sur un principe similaire, si ce n'est que que la liaison est disponible à la demande, et non permanente (24 heures sur 24). La liaison s'ouvre quand deux ordinateurs veulent l'utiliser pour échanger des informations. Quand les deux ordinateurs ont cessé d'échanger des données, la ligne se ferme après un certain délai d'inactivité. Le prix de ces lignes RNIS sont proportionnelle au temps d'utilisation. Autant dire qu'il vaut mieux limiter la durée de transmission au mieux pour réduire le coût de ce genre de ligne.

Les réseaux mondiaux

[modifier | modifier le wikicode]Internet est une interconnexion de réseaux à l'échelle mondiale. C'est d'ailleurs ce qui lui a valu son nom : internet est l'abréviation de interconnection of networks. Environ 47000 réseaux de grande envergure, des réseaux autonomes, sont interconnectés pour former internet. Ces 47000 réseaux sont souvent des réseaux appartenant à des fournisseurs d'accès. Les informations qui transitent sur internet passent par des câbles en fibre optique. Les câbles qui relient ces 47000 réseaux parcourent le monde entier : pour donner un exemple, il y a environ 6 à 7 câbles qui traversent l’Atlantique qui permettent aux réseaux américains de communiquer avec les réseaux européens.

Au début, Internet n'était pas disponible pour le grand public, mais servait essentiellement aux grandes organisations. L'internet de l'époque était vraiment différent de l'internet actuel : non seulement les technologies utilisées n'étaient pas les mêmes, mais il n'y avait pas de sites web. En ce temps, internet servait surtout à échanger des données, télécharger de grands volumes de données. C'est dans les années 1990 que sont apparues les technologies qui ont permis la conception des sites web, à savoir l'HTML, les adresses URL et le protocole HTTP. De nos jours, internet est surtout utilisé par les particuliers pour consulter des sites web. L'ensemble des sites web accessibles sur internet est ce qu'on appelle le web : il faut ainsi faire la différence entre le web et internet, internet étant un réseau et le web un ensemble de sites web.

La classification en fonction des interconnexions : le client-serveur et le pair à pair

[modifier | modifier le wikicode]Les réseaux informatiques peuvent aussi être catégorisés selon la manière dont les ordinateurs échangent des données. On peut ainsi classer les réseaux en trois grands types :

- les architectures un tiers ;

- les architectures client-serveur ;

- les architectures pair à pair.

Un même réseau physique peut servir pour les trois. Si on prend internet, celui-ci permet à des ordinateurs de communiquer en client-serveur : c'est ce qui est fait lors de la consultation de sites web. Il permet aussi les échanges en pair à pair : les applications de téléchargement basées sur le protocole BitTorrent utilisent des échanges en pair à pair.

|

|

Les réseaux organisés autour d'un terminal

[modifier | modifier le wikicode]

Les premiers réseaux locaux datent des années 1960. A cette époque, les ordinateurs étaient très cher et prenaient énormément de place : un ordinateur pouvait facilement remplir une pièce complète. Seules les grandes entreprises et services publics d'état pouvaient se payer ces ordinateurs. Il n'y avait donc pas un poste par personne : les organisations n'avaient qu'un seul ordinateur qu'il fallait se partager. Les utilisateurs n'avaient pas accès à l'ordinateur directement. Ils devaient passer par des terminaux, des systèmes qui permettaient d'afficher des informations et de saisir des commandes et du texte : ils étaient constitué d'un clavier, d'un écran, et de quelques circuits rudimentaires. Ces terminaux se contentaient d'envoyer ou de recevoir des informations au gros ordinateur central, qui traitait les demandes des terminaux une par une.

Cette organisation avec un seul ordinateur relié à des terminaux a survécu, et s'est même adaptée à l'ère internet. En effet, de nombreuses organisations utilisent encore des terminaux qui communiquent avec des serveurs via internet. Pensez à un distributeur automatique de billets : celui-ci n'est ni plus ni moins qu'un terminal assez évolué qui communique avec un serveur de la banque, via des connections internet. L'architecture un tiers correspond au cas où plusieurs terminaux sont reliés à un ordinateur central, peut importe que cette connexion se fasse via internet ou via un réseau local.

Les réseaux de type clients-serveurs

[modifier | modifier le wikicode]

L'architecture client-serveur est une amélioration de l'organisation précédente, la différence étant que les terminaux sont de véritables ordinateurs. Elle fait intervenir au minimum deux ordinateurs : un serveur et un ou plusieurs clients. Le serveur est un ordinateur qui contient des données utiles et très importantes à traiter, comme un site web, des données partagées sur internet, les documents d'une entreprise, etc. Les clients veulent avoir accès aux données présentes sur le serveur : pour cela, ils doivent envoyer une demande au serveur. Le serveur traitera cette demande après réception, et renvoie le résultat de la demande. La grosse différence entre un terminal et un client est que le terminal n'est pas un ordinateur, mais un matériel sans intelligence et qui n'a aucune capacité de calcul. Cette méthode est utilisée pour les sites web et les applications web : le site web est stocké sur le serveur, tandis que le client reçoit ces fichiers et affiche le site sur votre ordinateur.

Cependant, ce système a une ambiguïté majeure. Outre l'affichage et le stockage des données, un programme doit effectuer un paquet de traitements. Dans le modèle avec des terminaux, ces traitements étaient pris en charge par le serveur central : un terminal est un matériel sans intelligence et qui n'a aucune capacité de calcul. Mais un client est un vrai ordinateur qui peut parfaitement prendre en charge les calculs à faire. Ainsi, avec le système client-serveur, on ne sait pas où effectuer les traitements sur les données. De nos jours, on peut déporter les calculs aussi bien du côté du serveur que du côté client. Par exemple, on peut utiliser des technologies comme Javascript pour exécuter du code dans un navigateur web client. Mais dans d'autres situations d'entreprise, on peut déporter les calculs côté serveur. Dans le cas où les calculs sont majoritairement déportés du côté du serveur, le client est qualifié de client léger. Dans le cas contraire, on parle de client lourd.

Les réseaux pair à pair

[modifier | modifier le wikicode]

L'architecture pair à pair, aussi notée P2P, peut être vu comme une sorte d'amélioration du client-serveur. Dans le client serveur, les rôles de serveur et de client sont attribués définitivement. Mais avec le pair à pair, tout ordinateur peut alternativement être serveur et client. Pour mieux comprendre ce que cela signifie, on peut prendre l'exemple d'utilisation la plus connue du P2P : le transfert de fichiers. De nombreux logiciels utilisent des protocoles P2P, comme BitTorrent, pour permettre l'échange de fichiers entre utilisateurs. Ces protocoles permettent le téléchargement de fichiers demandés à partir d'autres "serveurs", ou alors envoyer des morceaux de fichiers aux autres clients. Ainsi, chaque ordinateur peut, avec ce logiciel, servir de client ou de serveur. Attention, cependant : c'est l'échange de fichiers qui est décentralisé, mais d'autres parties du protocole peuvent faire intervenir un serveur. La découverte des sources de téléchargement en est un bon exemple : selon le protocole, il peut être effectué en pair à pair ou en client-serveur. Cela permet de distinguer deux types d'architectures pair à pair :

- Avec du P2P centralisé, la mise en relation est réalisée par un serveur central, qui centralise les informations sur chaque client. Pour information, ces serveurs de mise en relation sont appelés des trackers, du moins pour le protocole BitTorrent. Ce serveur central contient une base de données qui mémorise quels sont les clients qui possèdent tel ou tel fichier. Cette BDD est mise à jour à chaque connexion d'un nouveau client. Quand un client se connecte au réseau P2P, il envoie au serveur la liste des fichiers qu'il est prêt à partager. Un client qui souhaite télécharger quelque chose a juste à demander au serveur de le mettre en relation avec un client qui possède le fichier voulu. Une fois la mise en relation faite, les deux clients vont se transmettre le fichier sans passer par le serveur.

- L'organisation précédente est à comparer avec le P2P décentralisé, où il n'y a pas de serveur central pour la mise en relation. Ici, les transferts de données se font de poste à poste, sans qu'il n'y ait de serveur bien précis. La mise en relation des clients s'effectue par des mécanismes bien plus complexes de découverte des clients, que nous n'aborderons pas ici.

Routage, bridging et diffusion

[modifier | modifier le wikicode]

Sur la plupart des réseaux, les ordinateurs sont rarement connectés directement entre eux. Mais cela ne les empêche pas de communiquer, les données pouvant être transmises indirectement, en passant par toute une série d'intermédiaires. Les données sont propagées de proche en proche et doivent trouver leur chemin vers le récepteur, trouver par quels intermédiaires passer pour arriver à destination. Tout le problème est de trouver un chemin d'intermédiaires entre l'émetteur et le récepteur, chemin qui doit de préférence être le plus court et/ou le plus rapide possible.

Cette problématique existe sur Internet et les réseaux étendus, mais elle existe aussi sur des réseaux locaux de grande taille, voire sur certains réseaux locaux très simples (dits en étoile). Sur les réseaux locaux, on lui donne le nom de bridging, alors que l'on parle de routage sur les réseaux étendus et sur Internet. Les intermédiaires/relais portent d'ailleurs des noms différents : routeurs pour les relais Internet, commutateurs/concentrateurs pour les relais sur les réseaux locaux.

- Dans la suite de la section, nous ferons la confusion entre routage et bridging, que nous désignerons tous deux sous le terme de routage. Cet abus de langage nous permettra de simplifier les formulations et l'écriture. Dans les faits, tout ce qui va être dit vaudra autant pour le routage sur les réseaux étendus que sur les réseaux locaux.

L'adressage réseau : adresses MAC et IP

[modifier | modifier le wikicode]Tout le problème du routage est de décider quand la donnée a atteint sa destination. Pour cela, il faut que les relais aient des moyens d'identifier les ordinateurs, par un système quelconque. Pour comprendre comment ce problème est résolu, nous allons faire une analogie entre un réseau et le système postal. Dans cette analogie, les personnes qui utilisent la poste sont équivalent aux ordinateurs d'un réseau, et les lettres sont équivalentes à des paquets de données échangés. Quand quelqu'un envoie une lettre, les relais postiers doivent identifier le destinataire, sans quoi ils ne savent où distribuer le courrier. Pour cela, on utilise une adresse, qui indique où il faut livrer la lettre. Sur les réseaux, on utilise le même mécanisme : chaque ordinateur reçoit une adresse, un identifiant qui permet de l'identifier. Mais les adresses réseaux sont bien plus simples que les adresses postales : elle n'ont pas d'organisation géographique et sont de simples numéros attribués arbitrairement.

On pourrait aussi faire une comparaison entre réseau téléphonique et réseau informatique, les deux étant très similaires et faisant usage de technologies très proches. Dans cette analogie, les ordinateurs sont équivalents aux téléphones, les données sont remplacées par des conversations téléphoniques, et les adresses par des numéros de téléphone.

| Réseau informatique | Réseau postal | Réseau téléphonique |

|---|---|---|

| Ordinateurs | Foyers/maisons/appartements | Téléphones |

| Adresse réseau | Adresse postale | Numéro de téléphone |

| Donnée échangée | Lettre | Conversation téléphonique |

| Routeurs et commutateurs | Relais de distribution postaux | Relais téléphoniques |

Précisons qu'il existe deux types d'adresses : les adresses physiques et les adresses logiques. Les premières sont des adresses utilisées sur les réseaux locaux, mais qui ne sont pas compatibles avec les réseaux étendu et Internet. Ce sont des adresses qui ne peuvent pas être utilisées pour identifier un ordinateur sur le net et dont la portée est limitée à un réseau local, guère plus. À l'inverse, les adresses logiques sont utilisées sur Internet et ont une portée très large, dépassant le réseau local de l'ordinateur. Les adresses physiques sont actuellement standardisées par le standard MAC, ce qui leur vaut le nom d'adresses MAC. Quant aux adresses logiques, elles sont standardisées par le protocole IP, ce qui leur vaut le nom d'adresses IP. Une telle séparation a son utilité : elle permet le remplacement d'un ordinateur sans pour autant changer son adresse internet. Par exemple, si un serveur tombe en panne et que l'on le remplace, il garde son adresse IP, alors que son adresse MAC change.

Routage par datagrammes et par circuits virtuels

[modifier | modifier le wikicode]Toute la problématique du routage est que les données envoyées arrivent à destination. Dans les grandes lignes, il existe deux types de routage distincts, qui fonctionnent sur des principes très différents : la méthode des datagrammes et la méthode des circuits virtuels.

- Sauf exceptions, les données envoyées sur un réseau le sont par blocs de taille fixe. Dans ce qui suit, nous allons appeler ces blocs de données des paquets (terme quelque peu impropre, mais passons).

Avec les datagrammes, chaque paquet contient toutes les informations nécessaires pour identifier le destinataire. Chaque paquet contient l'adresse du destinataire et éventuellement l'adresse de l'émetteur. Le principal avantage de cette méthode est qu'elle ne nécessite pas de maintenir une connexion entre source et destinataire. Le paquet est envoyé sans concertation préalable avec le destinataire. Pour savoir où envoyer les paquets reçus, les relais du réseau contiennent une table qui associe chaque adresse avec le prochain intermédiaire. Cette table porte des noms différents selon que l'on parle de routeurs ou de commutateurs : table de routage pour les routeurs et table CAM pour les commutateurs.

La méthode des circuits virtuels nécessite de maintenir une connexion active entre source et destinataire. Une fois la connexion établie, tout paquet émis par l'émetteur est envoyé automatiquement au récepteur désigné lors de la connexion. Avec elle, les paquets n'ont pas besoin de préciser leur destination : pas besoin d'insérer l'adresse de destination dans le paquet. Le destinataire est l'ordinateur avec lequel est connecté l'émetteur.

Les modes de transfert

[modifier | modifier le wikicode]Une transmission sur le réseau peut prendre différentes formes suivant le nombre de destinataires. Un ordinateur peut en effet vouloir communiquer avec un ordinateur bien précis, ou envoyer une donnée à plusieurs PC différents. Suivant le nombre de destinataire, on peut faire la différence entre Unicast, Anycast, Multicast et Broadcast.

Avec l'unicast, un ordinateur émet des données à destination d'un autre ordinateur bien identifié.

Avec l'anycast, un ordinateur émet des données vers un ordinateur qu'il ne connaît pas : l'émetteur ne connaît pas la destination de la donnée. L'ordinateur de destination n'est cependant pas choisi au hasard : c'est le protocole de routage qui choisit vers quel ordinateur émettre la donnée.

Avec le multicast, les données émises sont envoyées à un groupe d'ordinateur qui veulent recevoir cette donnée. Les ordinateurs qui veulent revoir la donnée se connectent à un serveur et s'inscrivent à un groupe de diffusion. Tous les ordinateur inscrits dans ce groupe recevront la donnée émise. C'est notamment utilisé lors du streaming d'évènements en live : on émet la donnée une fois, et celle-ci sera recopiée par les routeurs à toutes les personnes inscrites au groupe que le routeur connaît. Pour faire simple, le groupe possède une adresse logique (une IP) qui permet de l'identifier. Quand une donnée est envoyée à l'adresse du groupe, le serveur reçoit le paquet et en envoie des copies à tous les ordinateurs du groupe. L'adresse IP du serveur/groupe est appelée une adresse multicast.

Avec le broadcast, le paquet émis est envoyé à tous les ordinateurs d'un réseau ou sous-réseau (un réseau local le plus souvent). Selon que le paquet se propage dans un réseau local ou sur internet, on distingue deux formes de broadcast.

- Le broadcast limité a une portée limitée au réseau local de l'émetteur. Le paquet est envoyé aux voisins de l'ordinateur émetteur, mais reste confiné dans le réseau local : il ne passe pas les routeurs, mais est propagé par les commutateurs/concentrateurs.

- Le broadcast dirigé est similaire au précédent, sauf que le paquet n'est pas confiné dans un réseau local et peut passer les routeurs pour se déplacer sur internet.

|

|

|

|

Précisons une chose sur le broadcast : qu'il soit dirigé ou non, toute transmission en broadcast va se propager et atteindre un certain nombre d'ordinateurs. L'ensemble des ordinateurs d'un réseau local, pour un broadcast limité, un ensemble d'ordinateurs bien précis sur Internet (broadcast dirigé). L'ensemble des ordinateurs qui reçoit une transmission broadcast porte un nom : c'est le domaine de diffusion.

Les topologies logiques

- Dans le contenu suivant, nous parlerons de nœuds pour désigner tout ce qui est connecté au réseau. Ce terme regroupe un peu de tout : ordinateurs, imprimantes, serveurs, routeurs, commutateurs, et bien d'autres matériels réseau. Nous utiliserons cette dénomination pour alléger l'écriture.

Il n'existe pas 36 façons différentes de relier les ordinateurs entre eux dans un réseau et chaque manière a ses avantages et inconvénients. Afin de s'y retrouver, les réseaux peuvent également être catégorisés par la manière dont les nœuds sont reliés dans un réseau. La connectivité des nœuds porte un nom : c'est la topologie du réseau. Formellement, la notion de topologie peut s'appliquer à tout type de réseaux, y compris des réseaux MAN, WAN, ou plus large encore. Mais force est de constater que l'on parle rarement de la topologie des réseaux étendus, qui est souvent très complexe. Par contre, la topologie des réseaux locaux est d'une grande importance.

Les types de topologies

[modifier | modifier le wikicode]Il existe différents types de topologies, mais les principales sont illustrées dans le schéma ci-dessous. On voit que les topologies possibles s’appellent : la topologie en bus, en anneau, en arbre, linéaire, maillée (totalement ou partiellement), en étoile et hybride (un mélange des précédentes).

- La topologie en bus correspond au cas où tous les nœuds sont connectés à un unique fil, à un unique support de transmission matériel.

- La topologie totalement maillée est celle où tous les ordinateurs sont reliés à tous les autres. Le nombre de liens est alors important (proportionnel au carré du nombre d’ordinateurs à relier).

- La topologie hybride est équivalent à une topologie maillée à laquelle on aurait retiré quelques liaisons point-à-point, pour économiser des liens sans trop diminuer la performance du réseau.

- La topologie en étoile est celle où les nœuds sont reliés à un équipement réseau central. Le nombre de liens est proportionnel au nombre d'ordinateurs du réseau, ce qui est peu. Le nombre d'intermédiaire est faible (seulement un), ce qui fait que le matériel réseau nécessaire pour créer un réseau en étoile est particulièrement simple et peu cher. La moindre panne de l'équipement central fait tomber tout le réseau : les ordinateurs ne peuvent plus communiquer entre eux.

- La topologie linéaire est celle en forme de chaine. Tous les ordinateurs sont reliés à deux voisins, sauf les deux nœuds au bout de la chaine.

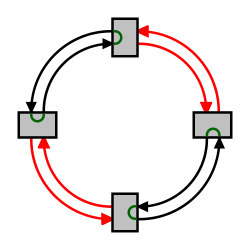

- La topologie en anneau est celle en forme d'anneau. Tous les ordinateurs sont reliés à deux voisins, sans exception. Elle est équivalente à une topologie linéaire dont on aurait relié entre eux les deux bouts.

- En théorie, les réseaux sans-fils sont regroupés dans une catégorie à part, du fait de l’inexistence de liaisons point-à-point sur ces réseaux).

Chacune a des avantages et inconvénients. Par exemple, certaines utiliseront beaucoup de liaisons point-à-point, alors que d'autres seront relativement économes : il faudra prévoir plus ou moins de câbles, de fils, et d'équipement réseau suivant la topologie. De plus, certaines topologies ne permettent pas à deux nœuds de communiquer directement. Les données doivent alors passer par des nœuds intermédiaires et se propager dans le réseau de proche en proche. Une conséquence assez fâcheuse est que la panne de certains nœuds peut empêcher des ordinateurs de communiquer. De plus, plus le nombre d'intermédiaires entre deux ordinateurs est grand, plus les performances seront mauvaises : le temps de transmission augmente avec le nombre d'intermédiaires. Autant cela n'a pas grande conséquence sur des réseaux locaux, autant cela devient plus problématique dans le cas de grands réseaux, tel certains WAN ou pour Internet.

| Topologie | Nombre de câbles (liaisons point-à-point), pour N ordinateurs | Résistance aux pannes |

|---|---|---|

| Topologie en bus | Un seul. | Toute coupure du câble scinde le réseau en deux sous-réseaux indépendants, voire fait tomber tout le réseau. |

| Topologie linéaire | N liaisons point-à-point (autant que de nœuds) | Toute coupure d'une liaison point-à-point scinde le réseau en deux sous-réseaux indépendants, voire fait tomber tout le réseau. |

| Topologie en anneau | N liaisons point-à-point (autant que de nœuds) | Dépend du réseau en question (voir la section sur le sujet plus bas) |

| Topologie en étoile | N liaisons point-à-point (autant que de nœuds) | Toute panne du nœud central fait tomber tout le réseau. |

| Topologie totalement maillée | liaisons point à point. | Résistance maximale à toute coupure de liaisons point-à-point ou de panne d'ordinateur. |

Généralement, les réseaux locaux utilisent des topologies en étoile, en bus ou en anneau, rarement en arbre. Les contraintes en terme de câblage font que les topologies maillées et hybrides ne sont pas très faciles à mettre en œuvre, du fait de leur grand nombre de liaisons point à point. Les réseaux étendus et Internet ne peuvent utiliser ces topologies, le nombre d'équipements et d'ordinateur étant bien trop important. Les réseaux WAN, MAN et Internet sont donc des réseaux maillés, de type hybride.

Les topologies diffusantes

[modifier | modifier le wikicode]

Nous allons commencer par voir deux types de topologies : la topologie en bus, et les réseaux sans-fils. Si on regroupe ces deux topologies ensemble, c'est parce qu'elles ont une particularité assez intéressante : quand une trame est envoyée, toutes les machines du réseau reçoivent la trame, mais seul l'ordinateur de destination est censé la prendre en compte. Cela leur vaut d'être appelés des réseaux de diffusion, sous-entendu que les données sont diffusées à tous les nœuds (un peu comme une diffusion radio, qui est diffusée sur toute une région, mais n'est écoutée que par quelques personnes). C’est une propriété naturelle pour les bus et les réseaux sans fils, qui font communiquer plusieurs nœuds avec un même support partagé (le bus ou les ondes sans-fils). Les autres réseaux n'ont pas cette particularité : la donnée peut passer par des intermédiaires, ou arriver directement à destination, mais en aucun cas la donnée n'est diffusée à tous les ordinateurs du réseau.

Un problème des réseaux de diffusion est que la sécurité n'est pas optimale. Tous les PC recevant les informations transmises, rien n’empêche un ordinateur (ou équipement réseau) d'espionner ce qui est transmis sur le réseau local : il lui suffit de prendre en compte la totalité des paquets qui sont envoyés sur le réseau. Un tel ordinateur est dit en mode « promiscious ». Il suffit d'installer un logiciel de capture de trames pour pouvoir surveiller le trafic réseau. Un tel logiciels est utile pour vérifier l’occurrence d'une intrusion ou infection, surtout quand il est couplé à un IDS (logiciel de détection d'intrusions) qui analyse les trames capturées.

Outre le problème précédent, il arrive que plusieurs composants tentent d'envoyer ou de recevoir une donnée sur le bus en même temps. Il se produit alors un conflit d'accès au bus, aussi appelé une collision. Cela pose problème si un composant cherche à envoyer un 1 et l'autre un 0 : tout ce que l’on reçoit à l'autre bout du fil est une espèce de mélange incohérent des deux données envoyées sur le bus par les deux composants. Détecter l'occurrence d'une collision et la corriger est essentiel pour qu'un bus fonctionne correctement. Inutile par construction pour les liaisons point à point, la gestion des collisions est essentielle pour tout réseau de diffusion. C'est pour cela que les protocoles des réseaux de diffusion gèrent ces collisions, et s'occupent du partage de l'accès au bus, d'où leur nom de protocoles à accès multiples. Diverses méthodes ont été inventées et intégrées aux protocoles les plus connus et nous verrons le fameux CSMA-CD plus tard dans ce cours.

La topologie en anneau

[modifier | modifier le wikicode]Dans les réseaux en anneau, les ordinateurs sont chacun relié à deux autres : un suivant et un précédent. Les données transmises font le tour de l'anneau avant d'être détruites : elles se propagent d'un ordinateur au suivant, jusqu’à arriver sur l'ordinateur de destination. Après réception de la trame, l'ordinateur de destination envoie un accusé de réception à l'émetteur, qui se propage dans le même sens que la trame envoyée.

Les jetons de contrôle d'accès

[modifier | modifier le wikicode]

Les réseaux en anneaux ont besoin d'un système de contrôle d'accès. Sans cela, on pourrait observer des phénomènes similaires aux collisions des réseaux diffusants. Pour éviter ceux-ci, chaque ordinateur devient émetteur a tour de rôle. Le droit d'émettre une donnée est modélisé par un jeton, une trame spéciale, pour laquelle un bit pré-déterminé est placé à 1. Il passe d'un ordinateur au suivant, à tour de rôle, et balaye tout le réseau en anneau régulièrement. Tant que l'ordinateur garde le jeton, il a le droit d'émettre une donnée et d'attendre un accusé de réception. D'ordinaire, le jeton est conservé dans un temps déterminé et fixe, le même pour tous les ordinateurs. Une exception, cependant : un ordinateur qui n’a rien à envoyer transmet immédiatement le jeton à l'ordinateur suivant.

L'utilisation d'un jeton permet à tous les ordinateurs d'avoir un accès équitable au réseau. Il garantit que tous les ordinateurs aient accès au réseau à un moment ou un autre. De plus, le temps avant de récupérer le jeton est obligatoirement fini. Le temps d'attente maximal est le temps que le jeton fasse le tour de l'anneau. C'est un avantage que les bus n'ont pas : un ordinateur peut potentiellement monopoliser le bus durant un temps indéterminé si rien n'est prévu dans la conception du bus. La conséquence est que les réseaux en anneau ont un meilleur débit si le nombre d'ordinateur du réseau est assez important. L’occurrence de nombreuses collision réduit le débit utile du bus, alors que les réseaux en anneau n'ont pas ce problème.

Les topologies en anneaux simples et doubles

[modifier | modifier le wikicode]Avec un anneau dit "simple", la panne d'un seul ordinateur met tout le réseau en panne, vu que l'ordinateur fautif ne peut plus propager les trames. Si un câble est coupé, les données ne peuvent pas atteindre l'ordinateur par le sens de propagation usuel. Mais elles le peuvent en passant dans l'autre sens. Le schéma ci-dessous illustre cette idée.

Les concepteurs de réseaux ont depuis longtemps trouvé comment propager les données dans les deux sens. Il suffit d'ajouter un second anneau qui propage les trames dans l'autre sens. Le réseau en anneau est donc composé de deux anneaux, qui propagent les jetons et trames dans des sens différents. Quand un câble est coupé, l'ordinateur ne va pas envoyer les trames sur celui-ci, mais va les renvoyer dans le sens inverse, sur l'autre anneau. Ce faisant, tout se passe comme si le premier anneau bouclait sur le second quand le câble est coupé. Si un seul câble est coupé, le réseau reste le même . Mais si deux câbles sont coupés, les choses deviennent plus compliquées : tout se passe comme si le réseau étant coupé en plusieurs sous-réseaux qui ne peuvent pas communiquer entre eux. Les schémas plus bas illustrent ces concepts basiques de cet anneau « auto-régénérateur » (Self-healing Ring en anglais).

|

|

|

Les topologies logiques

[modifier | modifier le wikicode]

On a vu dans le chapitre précédent comment plusieurs ordinateurs peuvent échanger des données via un réseau local, ce qui est le principal problème de la couche liaison. Nous nous sommes attardés sur les réseaux de diffusion et les liaisons point à point dans le chapitre précédent et il est temps de parler plus en détail des réseaux en étoile. Pour rappel, cela signifie que les ordinateurs du réseau sont reliés à un équipement central, qui reçoit les trames et les redistribue vers les autres ordinateurs. Cette topologie en réseau est une topologie physique, ce qui veut dire qu'elle décrit comment les ordinateurs sont physiquement reliés. Mais il est possible d'émuler un réseau en bus, en anneau, ou un réseau maillé avec une topologie en étoile. Cela nous pousse à faire la distinction entre la topologie physique, qui décrit comment les ordinateurs sont câblés, et la topologie simulée, appelée topologie logique.

Les topologies logiques en bus et maillées

[modifier | modifier le wikicode]Pour simuler un bus ou un réseau maillé à partir d'une topologie en étoile, il faut que l'équipement central soit ce qu'on appelle un commutateur ou un concentrateur. Ils sont tous deux des équipements réseaux avec plusieurs ports d'entrée/sortie, sur lesquels on vient connecter des composants réseaux : carte réseau, ordinateur, récepteur/émetteur WIFI, etc. Ces ports sont soit des ports d'entrées sur lesquels on peut recevoir des paquets de données, soit des ports de sorties sur lesquels on peut envoyer des données. Dans certains cas, les ports d'entrée et de sortie sont confondus : un même port peut servir alternativement d'entrée et de sortie.

La différence entre concentrateur et commutateur est la topologie simulée : bus pour le concentrateur et réseau maillé pour un commutateur.

- Un concentrateur redistribue chaque paquet reçu sur tous les autres ports, sans se préoccuper de sa destination. Pour le dire autrement, il simule une topologie en bus, alors que la topologie réelle est en étoile.

- Les commutateurs ont un fonctionnement similaire aux concentrateurs, si ce n'est qu'ils n'envoient les données qu'au composant de destination. Un commutateur simule donc une topologie totalement maillée à partir d'une topologie en étoile : on retrouve la distinction entre topologie réelle et logique.

|

Les réseaux logiques en anneau

[modifier | modifier le wikicode]

Il est possible de simuler un réseau en anneau avec un réseau en étoile, comme pour les réseaux en bus et les réseaux maillés. Cette fois-ci, l'équipement central n'est pas un concentrateur ou un commutateur, mais ce qu'on appelle une Multistation Access Unit (MAU). On connecte plusieurs ordinateurs sur ce boîtier, et ceux-ci seront alors reliés en anneau. On peut considérer que ce boîtier est un équivalent des concentrateurs et commutateurs, mais pour les réseaux en anneau.

Les modèles OSI et TCP

Les ordinateurs d'un réseau n'ont pas à être identiques : les différences de systèmes d'exploitation, de logiciels utilisés pour naviguer sur le net, et les autres différences du genre ne doivent pas avoir le moindre impact sur la communication entre deux machines. Par exemple, on peut parfaitement connecter des ordinateurs sous Windows avec des ordinateurs sous Linux. Pour cela, il a fallu inventer un certain nombre de standards réseau, appelés protocoles réseaux. Des organismes publics supranationaux s'occupent d'établir et de normaliser ces protocoles : ils consultent les grandes entreprises du web (Microsoft, Apple, et ainsi de suite), et les négociations sur ce qui doit être mis dans les protocoles sont souvent longues. Un cours sur le réseau ne peut décemment pas passer sous silence le fonctionnement des protocoles les plus connus. Peut-être en avez-vous déjà entendu parler : les protocoles IP ou TCP sont de loin les plus connus, sans compter les protocoles UDP ou MAC.

Chaque protocole gère des choses aux noms bizarres, comme le routage, la transmission des bits, l'adressage logique ou physique, et bien d'autres choses que nous allons aborder dans ce cours. Cependant, tous les protocoles ne se situent pas au même "niveau d'abstraction". Standardiser le codage des bits dans un câble réseau est plus proche de la machine que la gestion du routage. On pourrait croire que cette histoire assez vague de niveaux d'abstraction n'a pas grande importance. Il se trouve qu'il existe plusieurs classifications qui décrivent ces niveaux d'abstraction, et que celles-ci sont assez importantes. Ces classifications sont au nombre de deux : le modèle OSI et le modèle TCP/IP. Ces deux modèles forment l'ossature des chapitres qui vont suivre, aussi il est important de les voir. Une bonne présentation ne peut pas, en effet, mélanger des protocoles ou des connaissances de niveaux d'abstraction différents : nous n'allons pas passer du codage des bits sur un fil de cuivre aux protocoles de routage dans le même chapitre. Les modèles OSI et TCP/IP peuvent sembler assez compliqués, ceux qui les ont appris en cours de réseau ayant certainement eu du mal à comprendre leur principe. Mais il s'agit cependant d'un passage incontournable de la plupart des cours de réseau.

Les modèles OSI et TCP/IP

[modifier | modifier le wikicode]Ces modèles OSI et TCP/IP permettent de classer divers protocoles réseaux, à savoir des standards qui décrivent telle ou telle fonctionnalité que le réseau doit respecter. Par exemple, un protocole de la couche liaison va standardiser la façon dont deux ordinateurs vont s'échanger des données sur un câble réseau : comment les bits sont codés, comment détecter les erreurs de transmission, quelles sont les spécifications électriques des connecteurs et interfaces, etc. Ces protocoles sont classés selon leurs niveaux d'abstractions, dans ce qu'on appelle des couches. La définition d'une couche réseau est assez abstraite, mais on peut dire qu'il s'agit d'un ensemble de protocoles, qui sont au même niveau d'abstraction, qui ont des fonctions similaires.

Ces couches sont censées être bien individualisées, à savoir que la communication entre couches doit suivre un certain ordre. Des données à transmettre sur le réseau doivent d'abord passer par les protocoles de la couche la plus abstraite, dans le niveau d’abstraction supérieur, avant de passer par la couche d'en dessous, et ainsi de suite. Cela ne fait que traduire une évidence : avant de traiter le codage des bits du paquet, encore faut-il que les données aient été cryptées, que l'on ait identifié l'émetteur et le récepteur et ainsi de suite. Les opérations à effectuer doivent être faites dans un certain ordre si l'on veut que tout fonctionne, ce que traduit l'ordre des couches. Pour des raisons de simplicité, un protocole d'une couche peut utiliser les fonctionnalités de la couche immédiatement inférieure, mais pas des autres couches. Cela garantit qu'un paquet de données soit traité par toutes les couches dans le bon ordre, sans passer d'étapes.

Le modèle OSI

[modifier | modifier le wikicode]

Le modèle OSI est de loin le plus complet. Il décrit sept couches portant les noms de couche physique, liaison, réseau, transport, session, présentation et application. Les divers protocoles qui définissent le réseau et les communications sont donc répartis dans chaque couche, selon leur utilité. Il est d'usage de diviser ces sept couches en deux : les couches basses, qui se limitent à gérer des fonctionnalités de base, et les couches hautes, qui contiennent les protocoles plus élaborés.

Les couches basses, aussi appelées couches matérielles, s'occupent de tout ce qui a trait au bas-niveau, au matériel. Elles permettent d’envoyer un paquet de données sur un réseau et garantir que celui-ci arrive à destination. Elle est généralement prise en charge par le matériel et le système d'exploitation, mais pas du tout par les logiciels réseaux. Les couches basses sont donc des couches assez bas-niveau, peu abstraites. Les couches basses sont au nombre de trois. Pour résumer, ces trois couches s'occupent respectivement des liaisons point à point (entre deux ordinateurs/équipements réseaux), des réseaux locaux, et des réseaux Internet.

- La couche physique s'occupe de la transmission physique des bits entre deux équipements réseaux. Elle s'occupe de la transmission des bits, leur encodage, la synchronisation entre deux cartes réseau, etc. Elle définit les standards des câbles réseaux, des fils de cuivre, du WIFI, de la fibre optique, ou de tout autre support électronique de transmission.

- La couche liaison s'occupe de la transmission d'un flux de bits entre deux ordinateurs, par l'intermédiaire d'une liaison point à point ou d'un bus. Pour simplifier, elle s'occupe de la gestion du réseau local. Elle prend notamment en charge les protocoles MAC, ARP, et quelques autres.

- La couche réseau s'occupe de tout ce qui a trait à internet : l'identification des différents réseaux à interconnecter, la spécification des transferts de données entre réseaux, leur synchronisation, etc. C'est notamment cette couche qui s'occupe du routage, à savoir la découverte d'un chemin de transmission entre récepteur et émetteur, chemin qui passe par une série de machines ou de routeurs qui transmettent l'information de proche en proche. Le protocole principal de cette couche est le protocole IP.

Les couches hautes, aussi appelées couches logicielles, contiennent des protocoles pour simplifier la programmation logicielle. Elles requièrent généralement que deux programmes communiquent entre eux sur le réseau. Elles sont implémentées par des bibliothèques logicielles ou directement dans divers logiciels. Le système d'exploitation ne doit pas, en général, implémenter les protocoles des couches hautes. Elles sont au nombre de quatre :

- La couche transport permet de gérer la communication entre deux programmes, deux processus. Les deux protocoles de cette couche sont les protocoles TCP et UDP.

- La couche session, comme son nom l'indique, permet de gérer les connexions et déconnexions et la synchronisation entre deux processus.

- La couche présentation se charge du codage des données à transmettre. Elle s'occupe notamment des conversions de boutisme ou d'alignement, mais aussi du chiffrement ou de la compression des données transmises.

- La couche application prend en charge tout le reste.

Modèle TCP/IP

[modifier | modifier le wikicode]Le modèle TCP/IP est plus simple qu'OSI, avec seulement quatre couches : liaison, Internet, transport et application. La différence avec OSI est simplement que certaines couches ont été fusionnées. La couche liaison de TCP/IP regroupe notamment les couches physiques et liaison d'OSI. De même, la couche application de TCP/IP regroupe les couches session, application et présentation d'OSI.

|

|

L'encapsulation

[modifier | modifier le wikicode]Les données ne sont pas transmises telles quelles sur le réseau, car chaque protocole a besoin d'informations bien précises pour faire son travail. Par exemple, les protocoles de couche liaison ont besoin d'informations particulières, non présentes dans la donnée transmise, pour détecter les erreurs ou indiquer le récepteur. Même chose pour les protocoles TCP et UDP de la couche transport, qui ont besoin d'informations sur le processus émetteur et récepteur, qui ne sont pas dans la donnée transmise. Et ce problème nous amène à parler de l'encapsulation.

Les en-têtes des paquets

[modifier | modifier le wikicode]Pour résoudre le problème précédent, chaque protocole ajoute les informations dont il a besoin à la donnée transmise. Ces informations sont regroupées dans un en-tête, placé au début des données à transmettre. Plus rarement, certains protocoles ajoutent leurs informations devant, mais aussi derrière la donnée à transmettre : l'en-tête est complété par un pied (le terme anglais est : footer). Lorsqu'un protocole prend en charge un paquet de données, il lui ajoute un en-tête à son début. Avec cette méthode, les en-têtes de chaque couche sont séparés, placés les uns à côté des autres. Lors de la réception, cet en-tête sera enlevé : les couches supérieures n'ont pas besoin des en-têtes des couches inférieures.

Les Protocol Data Unit

[modifier | modifier le wikicode]Si la couche physique s'occupe de la transmission de bits individuels, ce n'est pas le cas des autres couches, qui traitent des paquets (données + en-tête/pied) contenant plusieurs bits. Les couches réseau, liaison et transport traitent des paquets de données de taille fixe (leur nombre de bits est fixé). Au-delà de la couche transport, les données ne sont pas structurées en paquets de taille fixe, mais en paquets de taille variable, qui dépendent du logiciel utilisé. Pour les couches liaison, réseau et transport, les paquets sont appelés des protocol data unit (PDU, unités de données d'un protocole, en français). Ils portent des noms différents selon la couche, vu qu'ils contiennent des en-têtes différents.

- Pour la couche liaison, l'unité est la trame.

- Pour la couche réseau, l'unité est le paquet.

- Pour la couche transport, l'unité est le segment pour le protocole TCP et le datagramme pour le protocole UDP.

| Couche OSI | Unité de transfert de données (PDU) | Taille du PDU | |

|---|---|---|---|

| Physique | Bit ou Symbole | Bit/symbole unique | |

| Liaison | Trame | Taille fixe, plusieurs bits, dépend du protocole utilisé. | |

| Réseau | Paquet | ||

| Transport | Segment (protocole TCP) | Datagramme (protocole UDP) | |

| Session | Paquets de taille variable | ||

| Présentation | |||

| Application | |||

Les supports de transmission

Pour que deux ordinateurs ou équipements réseau communiquent entre eux, il faut qu'ils soient reliés par quelque chose qui leur permet de transmettre de l'information. Ce quelque chose est ce qu'on appelle un support de transmission, qui est souvent un simple câble réseau, composé d'un fil de cuivre ou de fibre optique. Dans d'autres cas, la transmission se fait sans fils, avec des technologies à base d'infrarouges, d'ondes radio ou de micro-ondes. On pourrait notamment citer le WIFI, le Bluetooth, et bien d'autres. Pour résumer, il existe deux types de supports de communication : les câbles réseaux et le sans-fils.

Il faut cependant noter que les spécialistes en électricité et en électronique ont cependant un jargon un peu plus complexe que "avec fils" et "sans-fils". Ils parlent à la place de liaison guidée (avec fils) et non-guidée (sans fils). Dans les deux cas, le support de transmission va propager des ondes électromagnétiques, qui codent les informations transmises. Si le support est guidé, les ondes électromagnétiques ne pourront pas se disperser et seront contenues dans un espace restreint. Leur direction de propagation sera quelque peu contrôlée de manière à ce qu'elles aillent vers la destination et uniquement celle-ci. C'est le cas pour les fibres optiques ou les câbles réseaux : l'onde électromagnétique ne sort pas du câble et y reste confinée. Avec un support de transmission non-guidé, les ondes électromagnétiques vont se propager dans toutes les directions : elles ne seront pas guidées ou confinées dans un câble et seront émises dans toutes les directions à partir de la source. C'est le cas des ondes WIFI, Bluetooth et de toutes les technologies sans-fils en général.

Chaque support a ses avantages et inconvénients, le plus important étant sa portée. Les supports sans-fils n'émettent pas au-delà d'une certaine distance, au-delà de laquelle le signal transmis est trop atténué pour être capté. On observe un phénomène similaire sur les câbles réseaux, qu'ils soient en cuivre ou en fibre optique, mais il est plus sensible sur les câbles en fils de cuivre, raison pour laquelle les fibres optiques sont surtout utilisées pour de grandes distances. De manière générale, les technologies sans-fils ont une mauvaise portée : les ondes électromagnétiques vont se disperser dans l'environnement, facilitant leur atténuation. Les supports guidés (les câbles en cuivre et fibres optiques) n'ont pas ce problème : ils guident l'onde électromagnétique, qui ne peut pas s'échapper du câble.

Les supports de transmission guidés

[modifier | modifier le wikicode]Les câbles réseaux sont de loin la technologie la plus répandue dans nos foyers. Vous le savez peut-être, mais il existe grosso-modo deux types de câbles réseaux : les câbles basés sur des fils de cuivre, et la fibre optique. Peut-être savez-vous même que la fibre optique est bien plus rapide que la paire cuivre. Dans ce qui va suivre, nous allons voir aussi bien la paire cuivre, plus répandue dans nos foyers, que la fibre optique. Gardez à l'esprit que la fibre optique est certes plus puissante, mais aussi plus chère. C'est pour cela que les câbles réseaux qui relient votre ordinateur à votre box internet sont encore des câbles réseaux standards, en cuivre. Il faut savoir que ces câbles sont utilisés aussi bien pour construire des LAN que des réseaux plus importants. Par exemple, ce sont ces câbles qui relient votre box Internet à...Internet. Votre prise électrique est en effet reliée au réseau de votre opérateur par toute une série d'intermédiaires : les DSLAM, les BRAS, etc. Le fil qui relie votre box à ces intermédiaires était autrefois un fil téléphonique en cuivre, aux performances assez mauvaises. De nos jours, de plus en plus de clients passent à la fibre optique, ce qui signifie que le câble téléphonique qui relie votre habitation au DSLAM est en fibre optique, aux performances bien meilleures.

Les câbles en cuivre

[modifier | modifier le wikicode]Les câbles réseaux les plus simples sont de simples fils électriques. Ils sont composés d'un fil de conducteur, souvent du cuivre, entouré d'un isolant. Ce câble permet de transmettre n'importe quel signal électrique, qui est codé sois avec une tension, soit avec un courant. De nos jours, la majorité des signaux sont codés avec une tension électrique : on place une tension à un côté du câble, et cette tension est rapidement transmise à l'autre bout. Cette transmission est très rapide, bien plus qu'avec un courant. Cependant, un tel câble est sensible aux perturbations électromagnétiques, très fréquentes dans l'environnement. Si une perturbation électrique modifie la tension dans le fil, elle peut modifier les données transmises. Et il est alors impossible de savoir quelle était la donnée transmise à la base.

Les câbles coaxiaux sont composés d'un fil conducteur, entouré d'un isolant, lui-même entouré d'une couche de conducteurs (le blindage), le tout étant enroulé d'une protection isolante. Ces câbles réseaux sont assez performants. Leur débit varie de 56 Kilobits à plusieurs Gigabits. Ils sont utilisés autant pour les réseaux locaux que pour des liaisons à plus grande distance. Par exemple, les câbles réseaux qui font communiquer votre ordinateur et votre box internet sont de ce type. Mais les câbles qui relient votre prise téléphonique aux équipements de votre opérateur sont aussi des câbles coaxiaux (du moins, si vous n'avez pas la fibre). Comme dit auparavant, ces câbles transmettent aussi bien les signaux analogiques que numériques.

Pour éviter l'impact des perturbations, on peut utiliser deux fils pour la transmission, ce qui donne ce qu'on appelle une ligne bifilaire. Dans la plupart des cas, les deux fils sont torsadés, enroulés l'un autour de l'autre. On parle alors de paire torsadée. Mais certains fils ont une organisation plus complexe.

Les fibres optiques

[modifier | modifier le wikicode]

Les fibres optiques transmettent des signaux par le biais d'impulsions lumineuses. Ces impulsions lumineuses sont émises à un bout de la fibre optique, se propagent dans la fibre optique jusqu’à l'autre bout, où elles sont captées par un récepteur lumineux. La fibre optique est composée d'un cœur de matériau transparent, entouré par une gaine de matériau lui aussi transparent, l'ensemble étant entouré par une couche plastique de protection. Le cœur a un indice de réfraction inférieur à celui de la gaine. En conséquence, la lumière rebondit sur les parois de la gaine, et se propage dans le cœur par rebonds.

L'atténuation des supports de transmission

[modifier | modifier le wikicode]Les technologies sans fils utilisent comme support des ondes électromagnétiques. La transmission des bits s'effectue en utilisant l'onde électromagnétique comme support, via des techniques de modulation, que nous aborderons plus tard. L'émission et la réception de ces ondes se fait par des antennes, intégrées dans toute carte sans fil. Ces techniques sont évidemment moins fiables que le transport par un câble, fût-il optique ou en cuivre. Déjà, les ondes s'atténuent avec la distance qu'elles parcourent : au-delà d'une certaine distance, le signal transmis est trop faible pour être capté. La portée du sans fil est donc limitée, là où les câbles sont capables d'avoir une portée bien plus longue. De plus, les murs et autres objets ont tendance à atténuer les ondes électromagnétiques qui les traversent, réduisant l'amplitude du signal. Là encore, la portée est encore diminuée.

Les longueurs d'onde utilisées sont souvent des ondes radio, des micro-ondes, ou des ondes infrarouges. Les ondes infrarouges sont rarement utilisées dans les réseaux informatiques. Il faut dire que les infrarouges ne traversent pas les murs, sans compter que beaucoup d'objets émettent un rayonnement infrarouge qui peut biaiser le signal. Autant cela ne pose pas de problèmes pour transmettre le signal d'une télécommande, autant cela ne convient pas pour des réseaux sans fils LAN ou WAN. De même, les micro-ondes ne sont pas utilisées dans les réseaux sans fils, pour des raisons différentes. La totalité des réseaux sans fils actuels utilisent des ondes radio, c'est à dire des ondes dont la fréquence est comprise entre 9 kHz et 300 GHz.

Les technologies sans fils peuvent être utilisées aussi bien pour créer des réseaux de type PAN ou LAN que des WAN. On parle alors de Wireless PAN (WPAN), Wireless LAN (WWLAN) et de Wireless WAN (WWAN). Les technologies utilisées ne sont cependant pas les mêmes, les LAN, PAN et WAN ayant des contraintes différentes. Pour les réseaux LAN et PAN, on utilise surtout la technologie WIFI, ainsi que quelques autres. Les technologies sans fils WIFI sont standardisées dans la norme IEEE 802.11. Initialement dans sa version 802.11, cette norme a reçue plusieurs révisions, qui ont donné naissance aux versions 802.11a, 802.11b, 802.11g, 802.11n et 802.11ac. Chaque norme a un débit maximal et une portée différent, les performances s'améliorant à chaque version. Chaque norme définit plusieurs intervalles de fréquences, les canaux, sur lesquels un périphérique peut émettre/recevoir. Le nombre de ces intervalles de fréquences, les canaux, ainsi que leurs limites maximales et minimales sont définie par la norme utilisée.

La couche physique

Dans ce qui va suivre, nous allons parler de la première couche du modèle OSI : la couche physique. Pour rappel, cette couche physique s'occupe de la transmission physique des données entre deux équipements réseaux. Elle s'occupe de tout ce qui a trait au bas-niveau, au matériel : la transmission des bits, leur encodage, la synchronisation entre deux cartes réseau, etc. Elle définit les standards des câbles réseaux, des fils de cuivre, du WIFI, de la fibre optique, ou de tout autre support électronique de transmission.

Commençons ce chapitre par préciser une chose importante : les supports de transmission réseau ne transfèrent qu'un bit à la fois. En termes techniques, on dit que ce sont des liaisons séries. Il existe des liaisons qui échangent plusieurs bits en même temps, les liaisons parallèles, mais ils ne sont pas beaucoup utilisés dans le domaine du réseau. Ils sont plus utilisés à l'intérieur des circuits électroniques, dans les ordinateurs ou pour relier un PC à un périphérique. Pour résumer, les transmissions réseaux sont des flux de bits, transmis un par un.

Les bus et les liaisons point à point

[modifier | modifier le wikicode]Pour commencer ce chapitre, nous allons aborder la différence entre une liaison point à point et un bus. Notons que cette distinction ne vaut que pour les réseaux qui relient entre eux leurs nœuds avec un ou plusieurs fils électriques. Les réseau sans-fils sont volontairement omis pour le moment.

- Petite précision de vocabulaire pour la suite : Le composant qui envoie une donnée est appelé un émetteur, alors que ceux reçoivent les données sont appelés récepteurs.

Les liaisons point à point

[modifier | modifier le wikicode]Les liaisons point-à-point se contentent de connecter deux composants entre eux. Par exemple, le câble réseau qui relie votre ordinateur à votre box internet est une liaison point à point. Mais le terme est plus large que cela et regroupe tout ce qui connecte deux équipements informatiques/électroniques entre eux, et qui permet l'échange de données. Par exemple, le câble qui relie votre ordinateur à votre imprimante est lui aussi une liaison point à point, au même titre que les liaisons USB sur votre ordinateur.

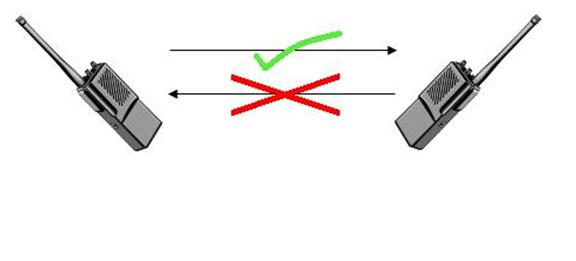

Les liaisons point à point sont classés en trois types, suivant les récepteurs et les émetteurs.

| Type de bus | Description |

|---|---|

| Simplex | Les informations ne vont que dans un sens : un composant est l'émetteur et l'autre reste à tout jamais récepteur. |

| Half-duplex | Il est possible d'être émetteur ou récepteur, suivant la situation. Par contre, impossible d'être en même temps émetteur et récepteur. |

| Full-duplex | Il est possible d'être à la fois récepteur et émetteur. |

| Liaison simplex |

|

|---|---|

| Liaison half-duplex | |

| Liaison full-duplex |

Les bus full duplex sont créés en regroupant deux bus simplex ensemble : un pour l'émission et un pour la réception. Mais certains bus full-duplex, assez rares au demeurant, n'utilisent pas cette technique et se contentent d'un seul bus bidirectionnel.

Les bus de communication

[modifier | modifier le wikicode]Sur un bus, on peut connecter un nombre assez important de composants, qui dépasse largement les deux nœuds d'une liaison point à point. Avec un bus, un émetteur va envoyer ses données à tous les autres récepteurs. Sur tous ces récepteurs, il se peut que seul l'un d'entre eux soit le destinataire du paquet : les autres vont alors ignorer le paquet, seul le destinataire traitant le paquet. Cependant, il se peut qu'il y ait plusieurs récepteurs comme destinataires : dans ce cas, les destinataires vont tous recevoir la donnée et la traiter. Ces bus permettent donc de faire des envois de données à plusieurs composants en une seule fois.

La synchronisation des nœuds

[modifier | modifier le wikicode]Les différents nœuds d'un réseau local ne vont pas tous à la même vitesse et ils doivent se synchroniser pour échanger des données. Cette synchronisation détermine le temps qui est mis pour transmettre un bit. Rappelons que, quel que soit le support de transmission, le transfert ne peut s'effectuer qu'un bit à la fois. Il existe deux méthodes pour synchroniser la communication, qui permettent de distinguer les liaisons synchrones des liaisons asynchrones.

Les liaisons/bus synchrones

[modifier | modifier le wikicode]Avec les liaisons synchrones, le support de transmission transmet un bit (ou un paquet de bits) toutes les x millisecondes ou microsecondes. Le temps de transmission d'un bit est appelé la période . L'inverse de la période est appelé la fréquence. Plus celle-ci est élevée, plus le fil peut transmettre de bits en une seconde : la transmission sera donc plus rapide.

La liaison entre deux nœuds transmet, outre les bits de la donnée, une tension de même période/fréquence qui évolue de manière cyclique, appelée signal d'horloge. Ainsi, le récepteur sait quand un nouveau bit est transmis : il a juste à regarde le signal d'horloge pour savoir quand démarre un nouvel envoi. Sur la plupart des bus, un nouvel envoi est signalé par le passage de 0 à 1 du signal d'horloge, autrement dit un front montant. Plus rarement, certains bus considèrent au contraire qu'un nouvel envoi est signalé par un front descendant, à savoir le passage de 1 à 0 du signal d'horloge.

Le signal d’horloge est souvent transmis sur un fil à part, complémentaire du fil sur lequel sont transmises les données.

Il va de soit que plus la fréquence est élevée, plus la liaison sera rapide et pourra transmettre de bits par seconde.

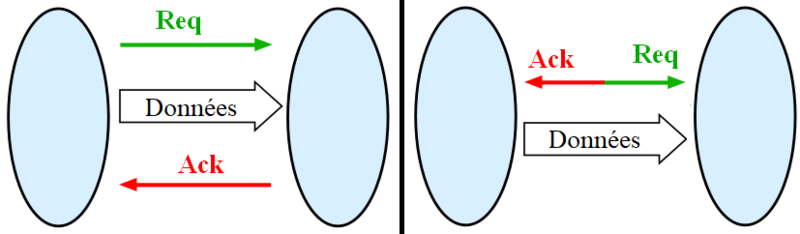

Les liaisons/bus asynchrones

[modifier | modifier le wikicode]Les liaisons asynchrones n'utilisent pas d'horloge pour synchroniser les nœuds du réseau. Pour se synchroniser, le premier nœud indique au second qu'il lui envoie une donnée. Le récepteur réceptionne la donnée et indique qu'il l'a prise en compte. Cette synchronisation se fait grâce à des fils spécialisés du bus/de la liaison, qui transmettent des bits particuliers.

Généralement, cette synchronisation utilise un système d'acquittement, qui utilise deux fils nommés ACK et REQ. Le fil REQ indique au récepteur que l'émetteur lui a envoyé une donnée, tandis que le fil ACK indique que le récepteur a fini son travail et accepte la donnée indiquée par REQ. Lorsqu'un nœud veut envoyer une information à un autre, celui-ci place le fil REQ à 1, afin de dire au récepteur : « attention, j'ai besoin que tu me fasses quelque chose ». Le récepteur va alors réagir et va faire ce qu'on lui a demandé. Une fois qu'il a terminé, il va alors positionner le fil ACK à 1 histoire de dire : j'ai terminé ! Plus rarement, un seul fil est utilisé à la fois pour la requête et l'acquittement : un 1 sur ce fil signifie qu'une requête est en attente (le second composant est occupé), tandis qu'un 0 indique que le second composant est libre. Ce fil est manipulé aussi bien par l'émetteur que par le récepteur. L'émetteur met ce fil à 1 pour envoyer une donnée, le récepteur le remet à 0 une fois qu'il est libre.

Le codage des bits

[modifier | modifier le wikicode]Avec les supports actuels, l'information à transmettre va être codée sous la forme d'une tension électrique ou de tout autre mesure électrique. Le transfert de cette information prend donc la forme d'ondes électromagnétiques qui se propagent de l'émetteur vers le récepteur, soit dans l’atmosphère (technologies sans-fils) soit sur un support matériel (câbles réseaux). Cette onde va représenter un flux de bits, la conversion entre flux de bits et onde électromagnétique étant appelé un codage en ligne. Nous allons commencer par voir comment un flux de bits peut être représenté/envoyé sur le support de communication avec des tensions/ondes électromagnétiques.

Généralement, un bit est codé avec une tension électrique, plus rarement avec un courant. Les méthodes pour faire la correspondance tension <-> bit envoyé sont assez nombreuses. On peut les classer grosso-modo en deux classes : les codes numériques, aussi appelés codes en ligne, et les codes analogiques. Les codes numériques transmettent un signal discontinu sur le support de transmission. Dit autrement, ils se bornent à représenter un bit par un certain niveau de tension, comme un +5 Volts ou -5 Volts. Le flux de bits peut donc être transmis tel quel sur le support de transmission. Les codes numériques sont à opposer aux codes analogiques, qui transmettent un signal continu. Généralement, ce signal est une tension sinusoïdale, qui est déformée selon le bit à transmettre.

Le codage en ligne

[modifier | modifier le wikicode]Il existe des méthodes relativement nombreuses pour coder un bit de données. Toutes codent celui-ci avec une tension, qui peut prendre un état haut (tension forte) ou un état bas (tension faible, le plus souvent proche de 0 volts).

Les codages non-différentiels

[modifier | modifier le wikicode]Pour commencer, nous allons voir les codages qui permettent de transférer un bit sur un seul fil (nous verrons que d'autres font autrement, mais laissons cela à plus tard). Il en existe de toutes sortes, qui se distinguent par des caractéristiques électriques qui sont à l’avantage ou au désavantage de l'un ou l'autre suivant la situation : meilleur spectre de bande passante, composante continue nulle/non-nulle, etc. Les plus courants sont les suivants :

- Le codage NRZ-L utilise l'état haut pour coder un 1 et l'état bas pour le zéro (ou l'inverse).

- Le codage RZ est similaire au codage NRZ, si ce n'est que la tension retourne systématiquement à l'état bas après la moitié d'un cycle d'horloge. Celui-ci permet une meilleure synchronisation avec le signal d'horloge, notamment dans les environnements bruités.

- Le codage NRZ-M fonctionne différemment : un état haut signifie que le bit envoyé est l'inverse du précédent, tandis que l'état bas indique que le bit envoyé est identique au précédent.

- Le codage NRZ-S est identique au codage NRZ-M si ce n'est que l'état haut et bas sont inversés.

- Avec le codage Manchester, aussi appelé codage biphasé, un 1 est codé par un front descendant, alors qu'un 0 est codé par un front montant (ou l'inverse, dans certaines variantes).

Faisons une petite remarque sur le codage de Manchester : il s'obtient en faisant un OU logique entre l'horloge et le flux de bits à envoyer (codé en NRZ-L). Les bits y sont donc codés par des fronts montants ou descendants, et l'absence de front est censé être une valeur invalide. Si je dis censé, c'est que de telles valeurs invalides peuvent avoir leur utilité, comme nous le verrons dans le chapitre sur la couche liaison. Elles peuvent en effet servir pour coder autre chose que des bits, comme des bits de synchronisation entre émetteur et récepteur, qui ne doivent pas être confondus avec des bits de données. Mais laissons cela à plus tard.

Les codages différentiels

[modifier | modifier le wikicode]Pour plus de fiabilité, il est possible d'utiliser deux fils pour envoyer un bit (sur un bus série). Ces deux fils ont un contenu qui est inversé électriquement : le premier utilise une tension positive pour l'état haut et le second une tension négative. Ce faisant, on utilise la différence de tension pour coder le bit, ce qui est plus fiable que d'utiliser des tensions deux fois plus élevées. Ce codage permet une meilleure résistance aux perturbations électromagnétiques, aux parasite et autres formes de bruits qui peuvent modifier les bits transmis. L'intérêt d'un tel montage est que les perturbations électromagnétiques vont modifier la tension dans les deux fils, la variation induite étant identique dans chaque fil. La différence de tension entre les deux fils ne sera donc pas influencée par la perturbation. Un tel codage est appelé un codage différentiel.

- Évidemment, chaque codage a son propre version différentielle, à savoir avec deux fils de transmission.

Ce type de codage est, par exemple, utilisé sur le protocole USB. Sur ce protocole, deux fils sont utilisés pour transmettre un bit, via codage différentiel. Dans chaque fil, le bit est codé par un codage NRZ-L.

Le codage par modulation

[modifier | modifier le wikicode]

Généralement, les signaux analogiques les plus simples sont formés de tensions sinusoïdales ou cosinusoïdales. IL est possible de transmettre un signal numérique à travers un signal analogique comme une sinusoïde. Celle-ci doit simplement subir quelques transformations via des techniques dites de modulation. Cela peut consister à modifier l'amplitude de la sinusoïde selon le bit à transmettre, ou à modifier sa fréquence ou sa phase. La sinusoïde non-déformée est appelée la porteuse. Cette porteuse étant un signal cyclique, elle se reproduit à l'identique toutes les x microsecondes, la durée d'un cycle étant appelée la période. Et qui dit période dit aussi fréquence, comme pour les signaux numériques. Il va de soit que plus la fréquence de cette porteuse est importante, plus celle-ci pourra transmettre un grand nombre de bits par secondes. La différence avec les codes numériques est qu'un cycle de porteuse peut parfaitement transmettre plusieurs bits à la fois. D'où des performances parfois plus importantes avec la modulation qu'avec les codes en ligne, dans une certaine mesure.

Techniques de modulation les plus simples

[modifier | modifier le wikicode]La méthode de modulation la plus simple est la modulation d'amplitude. Elle consiste à modifier l'amplitude de la sinusoïde en fonction du bit à transmettre. L'amplitude est alors maximale pour un 1 et minimale pour un 0. Il est aussi possible de transmettre un paquet de bits en une seule période : l'amplitude dépend alors de la valeur de ce paquet de bits. Par exemple, prenons un paquet de 2 bits. L'amplitude pourra prendre quatre valeurs, chacune correspondant à un paquet bien précis. Elle sera maximale pour le paquet 11, minimale pour le paquet 00 et intermédiaire pour les deux autres. On peut aussi augmenter le nombre de paliers : de 4 paliers pour deux bits, on peut passer à 8 paliers pour 3 bits, 16 pour 4 bits, et ainsi de suite. Mais cela demande des circuits capables de déceler des différences de tension assez fines, vu que la différence de tension entre deux paliers diminue avec le nombre de paliers, à tension maximale fixe.

La modulation de fréquence consiste à modifier la fréquence de la porteuse en fonction du bit à transmettre. La porteuse peut donc prendre plusieurs valeurs en fréquences, chaque valeur correspondant à un bit ou paquet de bit précis. Cette fois-ci, on trouve plusieurs paliers de fréquence, au lieu de paliers d'amplitudes. Cette forme de modulation est moins sensible aux interférences électromagnétiques, qui perturbent surtout l'amplitude du signal. Par contre, les circuits de détection de la fréquence, qui extraient le signal numérique transmis, sont plus complexes.

Utilisation dans les réseaux

[modifier | modifier le wikicode]Généralement, ces signaux analogiques sont bien adaptés aux supports de transmission sans fils, qui fonctionnement à base d'ondes électromagnétiques. Il est facile de créer des ondes électromagnétiques sinusoïdales, ce qui facilite fortement leur usage. Mais il faut signaler que ces câbles téléphoniques en cuivre peuvent transmettre aussi bien un signal numérique (un flux de bits) qu'un signal analogique (codé avec des signaux sinusoïdaux). Que ce soit pour transmettre le signal téléphonique ou le signal Internet, le câble de cuivre est utilisé pour transmettre des tensions sinusoïdales, dans un intervalle de fréquence fixe. Avant l'invention de l'ADSL, les fréquences utilisées étaient celles qui transmettent le signal téléphonique. On ne pouvait donc pas utiliser le téléphone en même temps qu'Internet. Les fréquences du signal téléphoniques étant assez faibles, la vitesse de transmission ne pouvait pas être très bonne. L'Internet de l’époque était donc limité à 56 Kbits par secondes. Les technologies DSL utilisent des fréquences différentes de celles utilisées pour transmettre le signal téléphonique. Les fréquences utilisées par l'ADSL sont illustrées dans le schéma à droite.

Les technologies (A)DSL utilisent une forme de codage par modulation assez impressionnante techniquement. L'ADSL utilise précisément plusieurs porteuses, dont la fréquence est multiple de 4,3125 kHz. L'ADSL utilise un intervalle de fréquences la bande de fréquences entre 0 Hz et 1,1 MHz, découpé en 255 intervalles plus petits. Chaque intervalle est associé à une porteuse, sauf le tout premier : on a donc 254 porteuses en tout. Certaines porteuses sont réservées à l'upload (transfert client -> internet) et d'autres au download (téléchargement d'internet vers le client). Le nombre de porteuses étant plus grand pour le téléchargement que pour l'upload, on en déduit que la vitesse d'upload est naturellement plus limitée que celle du download. Chaque porteuse peut convoyer environ 2000 bits par secondes. La méthode de modulation varie selon le modem ou la technologie ADSL utilisée, aussi nous ne pouvons pas détailler plus. Parler plus en détail de ces techniques de modulation demanderait cependant de faire un véritable cours de traitement du signal analogique, chose qui pourrait rebuter beaucoup de nos lecteurs. Aussi, nous n'irons pas plus loin dans les explications.

La couche liaison

Comme dit dans le chapitre précédent, un réseau local est un réseau contenant peu d'ordinateurs, qui sont reliés entre eux par des câbles réseaux, des routeurs ou des switchs. La gestion des réseaux locaux est le fait de la couche liaison, qui prend en charge les fonctionnalités suivantes : la mise en forme des données envoyés sur le réseau, l'identification des ordinateurs et la détection/correction des erreurs de transmission.

L'adressage physique

[modifier | modifier le wikicode]Pour simplifier, chaque ordinateur d'un réseau local reçoit un numéro qui permet de l’identifier : l'adresse physique. Pour être plus précis, l'adresse MAC est attribué aux cartes réseaux, mais aussi aux concentrateurs, aux routeurs, et à d'autres types de matériels. L'utilisation principale est celle des cartes réseaux : chaque carte réseau d'un ordinateur dispose de sa propre adresse physique. Par abus de langage, on dit que c'est l’ordinateur qui a cette adresse MAC, ce qui est rarement problématique. Mais il existe quelques rares cas où un ordinateur a plusieurs cartes réseaux, et donc plusieurs adresses physiques ! D'autres équipements, comme les routeurs ou les commutateurs ont une adresse physique, qui permet de s'y connecter si besoin. Cela peut, par exemple, servir à configurer un routeur/commutateur via un ordinateur connecté sur le réseau, sans avoir à se brancher directement sur le routeur/commutateur. Les administrateurs réseaux utilisent souvent cette possibilité pour configurer les routeurs d'un réseau depuis leur bureau, sans avoir à se déplacer dans plusieurs bâtiments pour chaque configurer chaque routeur à la main.

L'adressage MAC (Media Access Control)

[modifier | modifier le wikicode]

De nos jours, les adresses physiques sont définies par le standard MAC (Media Access Control). Avec ce standard, chaque adresse physique fait 6 octets (48 bits), et est appelée une adresse MAC.

Chaque équipement réseau dispose d'une adresse MAC unique au monde, attribuée par son fabricant. Mais l'utilisateur peut changer l'adresse MAC d'un réseau ou d'un ordinateur. Pour indiquer si l'adresse a été changée par l'utilisateur, l'adresse MAC contient un bit U/L. Il vaut 1 si l'adresse a été changée par l'utilisateur et 0 si l'adresse est l'adresse MAC originelle.

Les réseaux locaux eux-mêmes ont une adresse MAC, ce qui sert pour connecter des réseaux locaux entre eux. Si on envoie un paquet sur l'adresse d'un réseau, celle-ci sera envoyée à tous les ordinateurs du réseau : on parle alors de broadcast, ou encore de diffusion. Pour savoir si l'adresse MAC est celle d'un réseau ou d'un équipement réseau, chaque adresse MAC contient un bit I/G, qui vaut 1 si l'adresse est celle d'un réseau et 0 sinon.

| Bit I/G | Bit U/L | Reste de l'adresse MAC |

|---|---|---|

| 0 | 0 | L'adresse MAC n'a pas été modifiée par l'utilisateur. L'adresse MAC se décompose en une adresse de 24 bits qui identifie un ordinateur dans le réseau, et un Organizationally Unique Identifier (OUI) de 24 bits qui identifie le constructeur du matériel. |

| 0 | 1 | L'adresse MAC a été modifiée par l'utilisateur. |

| 1 | 0 | Le reste de l'adresse pointe vers un réseau local. |

| 1 | 1 | Le reste de l'adresse est intégralement remplie avec des bits à 1. Elle est interprétée comme étant une adresse de broadcast pour le réseau local. |

L'utilité de l'adressage MAC

[modifier | modifier le wikicode]L'adressage MAC permet de résoudre un problème se pose sur tous les réseaux (diffusants ou non). Grâce à lui, on peut déterminer le destinataire d'une trame pour qu'elle arrive à destination. Pour cela, chaque trame contient toutes les informations nécessaires pour identifier le destinataire. La trame précise son destinataire dans son en-tête de couche liaison, en donnant son adresse MAC.

Sur les réseaux diffusants, les trames sont envoyées à tous les ordinateurs en même temps, même à ceux qui ne sont pas destinataires de la donnée. Les récepteurs espionnent le support de transmission en permanence pour détecter les trames qui leur sont destinées, mais ils ne doivent pas prendre en compte les trames dont ils ne sont pas destinataires. Pour cela, toute trame indique quelle est son adresse MAC de destination. L'adresse en question est intégrée à la trame et est placée à un endroit précis, le plus souvent à son début. Les ordinateurs ont juste à extraire l'adresse MAC de la trame, et la comparer avec la leur pour savoir s'ils sont destinataires. Pour que la transmission soit la plus rapide, il vaut mieux que les périphériques sachent le plus rapidement si la trame leur est destinée, ce qui demande de mettre l'adresse au début de la trame.

Le codage du début et de la fin de transmission

[modifier | modifier le wikicode]Sur un réseau local, les données sont échangées sous la forme de paquets de données de taille fixe, qui sont émis par un ordinateur et se propagent dans le réseau local jusqu’à l'ordinateur de destination. Les paquets de données en question s'appellent des trames réseau. Le terme trame réfère aux données transmises : toutes les informations nécessaires pour une transmission sont regroupées dans ce qu'on appelle une trame qui est envoyée telle quelle.