Les opérations bit à bit/Version imprimable

Une version à jour et éditable de ce livre est disponible sur Wikilivres,

une bibliothèque de livres pédagogiques, à l'URL :

https://fr.wikibooks.org/wiki/Les_op%C3%A9rations_bit_%C3%A0_bit

Les opérations bit à bit

Pour commencer ce livre, nous devons d'abord parler des opérations logiques : que sont-elles, à quoi servent-elles ? Ces opérations logiques travaillent sur des suites de bits d'une longueur fixe, des nombres pour simplifier. Ces opérations modifient directement l'écriture binaire d'un nombre, la suite de bits correspondante. Il en existe de deux types, les instructions bit à bit et les instructions de décalage, que nous allons voir l'une après l'autre. Pour les connaisseurs, nous allons voir quelques opérations iconiques, comme les décalages et les rotations, mais aussi comment concevoir une unité de calcul 2 à 3 bits, les masques et quelques autres opérations.

Les opérations bit à bit proprement dit

[modifier | modifier le wikicode]Les instructions logiques les plus courantes sont au nombre de 4 : le NON, le ET, le OU, et le XOR. Toutes ces instructions vont travailler sur des bits individuels d'un ou de deux nombres, et leur faire subir une opération bien précise. Cette opération prend deux bits (un seul pour le NON) et donne un résultat codé sur un bit. Le fonctionnement de cette opération peut être définie par ce qu'elle fait sur un bit, son comportement étant résumé dans un tableau qu'on appelle la table de vérité. Leur résultat n'est pas vraiment interprétable mathématiquement, ou alors avec un sens vraiment idiosyncratique. La plus simple est clairement l'opération NOT, qui inverse tous les bits d'un nombre. Mais il est aussi possible de prendre deux nombres, de faire un ET/OU/XOR entre les bits de même poids, et de renvoyer le tout en guise de résultat. Formellement, ce sont les seuls types d'opérations bits à bit : l'inversion des bits d'un nombre, un ET entre deux nombres, un OU entre deux nombres, et un XOR entre deux nombres (avec leurs dérivées, tel un NAND ou un NOR).

L’opération d'inversion (NOT)

[modifier | modifier le wikicode]L'inversion bit à bit va inverser tous les bits d'un nombre : les 0 deviennent des 1, et les 1 deviennent des 0. Exemple : le nombre 01110011 va devenir 10001100.

La table de vérité du NOT est celle-ci :

| Bit A | Résultat (NOT A) |

|---|---|

| 0 | 1 |

| 1 | 0 |

Le NOT d'un bit et/ou d'un nombre sera noté comme ceci : .

| Notation | |||

|---|---|---|---|

| dans ce livre | |||

| quelques autres notations | |||

On peut remarquer qu'inverser deux fois de suite un bit redonne le bit initial. Autrement dit, .

Le résultat de cette opération dépend de l'encodage du nombre. Plus précisément, l'interprétation du résultat n'est pas la même selon que le nombre inversé soit non-signé, en complément à 1, en complément à 2, etc.

- Pour un entier en complément à 1, le NOT sert à obtenir l'opposé d'un nombre : dit autrement, .

- Pour un entier en complément à deux, le NOT donne l'opposé d'un nombre auquel on aurait retranché 1 : .

- Pour un entier non-signé, le NOT va donner la valeur .

Le dernier résultat est facile à comprendre. On sait que la somme donne un nombre de n bits dont tous les bits sont à 1. Un tel nombre vaut exactement, par définition, . On a donc , ce qui donne le résultat précédent avec quelques manipulations algébriques triviales. L'image de droite montre ce que fait l'opérateur NOT sur un entier en complément à deux.

L'opération ET (AND)

[modifier | modifier le wikicode]Vient ensuite le ET bit à bit, aussi appelé AND bit à bit. Celui-ci prend deux nombres en opérandes et donne un nombre comme résultat. Sur ces deux nombres, il va prendre les bits qui sont à la même place et va effectuer dessus une petite opération qui donnera le bit du résultat. Cette opération est un simple AND binaire. Ce AND binaire prend deux bits, A et B, et fonctionne comme ceci :

| Bit a | Bit b | Résultat |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 0 |

| 1 | 0 | 0 |

| 1 | 1 | 1 |

Cet opérateur AND bit à bit est symbolisé comme ceci : . Le symbole de l'opérateur ET ressemble à celui d'un produit car l'opérateur donne effectivement le résultat de la multiplication bit à bit.

Exemple :

| Notation | |||

|---|---|---|---|

| dans ce livre | |||

| quelques autres notations | a AND b | a & b | |

L'instruction AND bit à bit est commutative :

Elle est aussi associative :

Elle est aussi distributive avec le OR bit à bit :

On peut aussi remarquer qu'elle dispose de la propriété d'idempotence :

Petite remarque :

De plus,

L'opération OU (OR)

[modifier | modifier le wikicode]Vient ensuite le OR bit à bit. Il fonctionne comme le AND bit à bit sauf qu'il effectue un OR binaire entre les bits du nombre. Ce OR binaire prend deux bits, A et B, et fonctionne comme ceci :

| Bit a | Bit b | Résultat |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 1 |

| 1 | 0 | 1 |

| 1 | 1 | 1 |

Cet opérateur OR bit à bit est symbolisé comme ceci : . Pour éviter toute ambiguïté en présence d'addition, nous utiliserons parfois le symbole dans la suite du cours.

Exemple :

| Notation | ||

|---|---|---|

| dans ce livre | (a ne pas confondre avec l'addition !) | |

| dans ce livre | ||

| quelques autres notations | a OR b | |

L'opérateur OR est commutatif :

Il est aussi associatif :

Il est aussi distributif avec le AND bit à bit :

On peut aussi remarquer qu'il dispose de la propriété d'idempotence :

Petite remarque :

L'opération OU exclusif (XOR)

[modifier | modifier le wikicode]Vient ensuite le OU exclusif bit à bit, appelé XOR en anglais (eXclusive OR). Il fonctionne comme le AND et le OR bit à bit sauf qu'il effectue un XOR binaire entre les bits du nombre. Ce XOR binaire prend deux bits, A et B, et fonctionne comme ceci :

| Bit a | Bit b | Résultat |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 1 |

| 1 | 0 | 1 |

| 1 | 1 | 0 |

Le résultat est 0 quand les deux bits sont égaux, et 1 quand les deux bits sont différents.

Cet opérateur XOR bit à bit est symbolisé comme ceci : comme une addition bit à bit sans retenue.

Exemple :

| Notation | ||

|---|---|---|

| dans ce livre | ||

| quelques autres notations | a XOR b | a^b |

L'opérateur XOR est commutatif :

Il est aussi associatif :

Petite remarque :

Autre remarque :

Les décalages et rotations

[modifier | modifier le wikicode]À côté des opérations précédentes, on trouve les opérations de décalage, qui décalent un nombre binaire de un ou plusieurs rangs vers la gauche ou la droite. A priori, cette opération n'a rien de compliqué, à un détail près : lorsqu'on décale un nombre, certains bits sont inconnus, ce qui laisse des vides qu'il faut combler. Pour résoudre ce petit problème, il existe diverses solutions, qui donnent naissance à plusieurs types de décalages : les décalages logiques, les décalages arithmétiques et les rotations.

Les décalages logiques

[modifier | modifier le wikicode]L'idée la plus immédiate serait de remplir ces vides avec des zéros, ce qui donne un décalage logique. Pour un décalage vers la gauche, l'opération similaire en décimal serait d'ajouter des zéros à la fin d'un nombre, ce qui serait équivalent à multiplier par 10, 100, 1000, bref : par une puissance de 10. Un décalage à droite reviendrait en binaire à décaler la position de la virgule d'un cran vers la gauche et à oublier ce qu'il y a après la virgule, ce qui revient à diviser par une puissance de dix. Cette logique vaut aussi pour le décalage en binaire, si on se rappelle toutefois qu'on doit compter en base 2. Un décalage logique à gauche correspond donc à une multiplication ou division par 2, 4, 8, 16, ..., bref, par une puissance de deux.

|

|

L'utilité principale des opérations de décalage est donc qu'elles permettent de faire simplement des multiplications ou divisions par , pour les entiers non signés. Précisément, un décalage vers la gauche de rangs est équivalent à une multiplication par , alors que le décalage vers la droite qui revient à diviser un nombre entier par . Cette propriété est souvent utilisée par certains compilateurs, qui préfèrent utiliser des instructions de décalages (qui sont des instructions très rapides) à la place d'instructions de multiplication ou de division qui ont une vitesse qui va de moyenne (multiplication) à particulièrement lente (division). Il faut cependant signaler que lorsqu'on effectue un décalage à droite, certains bits de notre nombre vont sortir du résultat et être perdus : le résultat est tronqué ou arrondi vers zéro. Plus précisément, le résultat d'un décalage à droite de n rangs sera égal à la partie entière du résultat de la division par .

Le tableau ci-dessous indique les notations utilisées pour les décalages.

| Notation | ||

|---|---|---|

| Décalage à gauche | Décalage à droite | |

| dans ce livre | ||

| quelques autres notations | ||

Les décalages arithmétiques

[modifier | modifier le wikicode]

Le décalage logique ne donne cependant pas de bons résultats avec des nombres signés négatifs : on obtient un résultat qui n'a pas grand sens mathématiquement. Il faut dire que le bit de signe est alors remplacé par un zéro, ce qui peut inverser le signe du résultat. Une solution intuitive est de conserver le bit de signe, de ne pas le décaler. Mais en faisant cela, que mettre dans le bit situé juste avant le bit de poids fort après décalage ? On pourrait penser mettre un zéro dedans, mais cela ne donnerait pas le bon résultat avec les nombres négatifs. La solution est en fait de recopier le bit de signe dans ce bit. Tout se passe comme si on faisait le décalage normalement, comme un décalage logique, mais que le bit de poids fort était cependant conservé au lieu d'être remplacé par un zéro. Ce faisant, le bit de signe est conservé et le décalage est malgré tout effectué correctement.

En faisant cela, on obtient un décalage qui effectue correctement des multiplications/divisions par sur des nombres signés. De tels décalages sont appelés décalages arithmétiques (arithmetical shift en anglais). La différence avec un décalage logique est la méthode d'arrondi des nombres négatifs. Avec les décalages arithmétiques, les nombres négatifs sont arrondis vers moins l'infini. Pour donner un exemple, 92 sera arrondi en 4, tandis que −92 sera arrondi en −5.

Les rotations de bits

[modifier | modifier le wikicode]Les rotations sont identiques aux décalages, à part que les bits qui sortent du nombre sont ceux qui rentrent pour combler les vides.

|

|

Ces opérations sont très utiles en cryptographie, et sont notamment très utilisées dans certains algorithmes de chiffrement. Les rotations sont aussi très utiles dans certains cas particuliers dans lesquels on doit manipuler des données bits par bits. Par exemple, un calcul du nombre de bits à 1 dans un nombre peut s'implémenter de façon naïve avec des instructions de rotation.

Le tableau ci-dessous indique les notations utilisées pour les rotations.

| Notation | |

|---|---|

| Rotation à gauche | Rotation à droite |

Quelques règles de calcul utiles

[modifier | modifier le wikicode]Dans la suite du cours, nous ferons souvent usage de quelques équations qui mélangerons les différentes opérations bit à bit. Ne vous étonnez donc pas si vous voyez des équations de ce style :

Il existe quelques règles mathématiques qui nous permettront de simplifier de telles équations.

Les règles pour les expressions booléennes

[modifier | modifier le wikicode]Commençons par les règles qui impliquent uniquement des opérations bit à bit/booléens. Nous en avons déjà vu la plus grande partie plus haut, en parlant de la distributivité et de l'associativité des différents opérateurs. En voici la liste complète :

| Commutativité |

|

|---|---|

| Associativité |

|

| Distributivité |

|

| Idempotence |

|

| Élément nul |

|

| Élément Neutre |

|

| Loi de De Morgan |

|

| Complémentarité |

|

Les règles pour les expressions booléennes et arithmétiques

[modifier | modifier le wikicode]Il est parfaitement possible de mixer des opérations booléennes avec des opérations arithmétiques. Par exemple, on peut se demander ce que vaut , un calcul qui sera notamment beaucoup utilisé dans la suite du cours. Les règles qui régissent les mélanges/interactions entre opérations mathématiques et opérateurs bit à bit dépendent du codage des nombres, notamment pour les nombres signés. Nous allons supposer que les nombres signés sont codés en complètement à deux. Les règles qui en découlent sont résumées dans le tableau suivant :

| Addition |

|

|---|---|

| Soustraction | |

| Opposé | |

Les équations pour l'opposé et la soustraction peuvent se déduire assez facilement de l'équation , définition de l'opposée d'un nombre en complètement à deux. En guise d'exercice, vous pouvez tenter d'en déduire l'équation . Si vous utilisez les règles sur les opérateurs booléens, vous devriez y arriver sans trop de peine.

Les règles pour les expressions booléennes et comparaisons

[modifier | modifier le wikicode]Il est parfaitement possible de comparer des expressions booléennes, et certaines égalités ou inégalités sont toujours vraies. On peut rapidement se rendre compte que :

Pour les opérations mathématiques, les relations suivantes sont importantes à connaître :

- ;

- ;

- .

Les masques

Dans ce chapitre, nous allons aborder la technique dite des masques. Elle permet de mettre à 0 ou à 1 certains bits dans un nombre. Les bits à modifier peuvent être choisis et il est possible de modifier certains bits sans toucher aux autres. Nous allons d'abord voir les masques proprement dit, mais aussi à quoi cette technique peut servir. Dans ce qui va suivre, nous allons d'abord voir comment modifier un bit dans un nombre, sans toucher aux autres. Nous verrons notamment les champs de bits et quelques autres applications.

Modifier un bit

[modifier | modifier le wikicode]Modifier des bits individuellement dans un nombre demande naturellement d'utiliser des opérations bit à bit. Suivant ce que l'on veut faire, l'instruction utilisée sera différente, mais le principe reste le même. Il suffit d'effectuer une instruction bit à bit entre notre nombre, et une constante bien précise.

Mettre un bit à 1

[modifier | modifier le wikicode]Tout d'abord, nous allons voir comment mettre à 1 un bit dans un nombre. Pour cela, nous allons utiliser une opération bit à bit entre le nombre en question, et un nombre appelé masque qui indique les bits à mettre à 1. Si le bit du masque est à 0, cela signifie que le bit du nombre, situé à la même place, ne doit pas être modifié. Mais si le bit du masque est à 1, le bit du nombre devra être mis à 1. Par exemple, pour modifier le 4éme bit d'un nombre en partant de la droite, le masque est une constante dont le 4éme bit en partant de la droite est 1, et le reste des bits est à 0, soit la constante : 000000001000.

Nous allons devoir trouver quelle opération bit à bit convient. Rien de compliqué au demeurant : il suffit d'écrire la table de vérité de cette opération et de reconnaître la porte logique.

| Nombre | Masque | OURésultat |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 1 |

| 1 | 0 | 1 |

| 1 | 1 | 1 |

On remarque que l’opération bit à bit à effectuer est un OU.

Mettre un bit à 0

[modifier | modifier le wikicode]Mettre un bit à 0 dans un nombre fonctionne sur le même principe que mettre un bit à 1 : on effectue une opération bit à bit entre le nombre en question et un masque qui indique quels bits mettre à 0. Encore une fois, écrire la table de vérité de l'opération nous donne l'opération bit à bit à effectuer. Il s’avère que c'est un ET bit à bit.

| Nombre | Masque | ETRésultat |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 0 |

| 1 | 0 | 0 |

| 1 | 1 | 1 |

On peut se demander à quoi peut bien servir de mettre à 0 certains bits. L'utilité première est d'accéder à un bit particulier dans un nombre, ou à des groupes de bits. Un cas classique est celui de la sélection du bit de signe, pour calibrer certaines opérations arithmétiques. Dans ce cas, on va mettre à zéro les bits inutiles avant d'effectuer un décalage pour caler ces bits à droite. Mais d'autres utilisations plus importantes existent. Par exemple, vous avez peut-être déjà entendu parler des masques de sous-réseau, dans des cours sur le protocole IP. Ceux-ci permettent de mettre à 0 certaines bits d'une adresse IP pour obtenir une adresse de sous-réseau. L'obtention de l'adresse de sous-réseau s'effectue avec un simple ET entre l'adresse IP et le masque de sous-réseau. Et ce n'est là qu'un exemple parmi tant d'autres !

Inverser un bit

[modifier | modifier le wikicode]Le même raisonnement que pour les deux opérations précédentes vaut aussi pour ce qui est de l'inversion d'un bit. On obtient alors l'opération XOR à partir de la table de vérité.

| Nombre | Masque | XORRésultat |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 1 |

| 1 | 0 | 1 |

| 1 | 1 | 0 |

Les champs de bits

[modifier | modifier le wikicode]Dans certains cas précis, il arrive que certaines informations soient codées sur un nombre limité de bits, qui peuvent être rassemblés dans un seul entier. De telles structures, formées en concaténant des bits dans un seul entier, sont appelées des champs de bits. Pour donner un exemple d'utilisation, supposons que j'ai regroupé plusieurs bits, dont chacun a une signification bien précise. Par exemple, je peux regrouper les droits d'accès dans un fichier dans un nombre : un des bits du nombre me dira alors si je peux écrire dans le fichier, un autre me dira si je peux le lire, un autre si… Bref, si jamais je veux modifier mes droits en écriture de mon fichier, je dois mettre un bit bien précis à 1 ou à 0 (suivant la situation). Cela peut se faire facilement en utilisant une instruction bit à bit entre ce nombre et une constante bien choisie.

Un autre cas typique est celui où un développeur compacte plusieurs données dans un seul entier. Par exemple, prenons le cas d'une date, exprimée sous la forme jour/mois/année. Un développeur normal stockera cette date dans trois entiers : un pour le jour, un pour le mois, et un pour la date. Mais un programmeur plus pointilleux sera capable d'utiliser un seul entier pour stocker le jour, le mois, et l'année. Pour cela, il raisonnera comme suit :

- un mois comporte maximum 31 jours : on doit donc encoder tous les nombres compris entre 1 et 31, ce qui peut se faire en 5 bits ;

- une année comporte 12 mois, ce qui tient dans 4 bits ;

- et enfin, en supposant que l'on doive gérer les années depuis la naissance de Jésus jusqu'à l'année 2047, 11 bits peuvent suffire.

Dans ces conditions, notre développeur décidera d'utiliser un entier de 32 bits pour le stockage des dates :

- les 5 bits de poids forts serviront à stocker le jour ;

- les 4 bits suivant stockeront le mois ;

- et les bits qui restent stockeront l'année.

Dans cette situation, le développeur qui souhaite modifier le jour ou le mois d'une date devra modifier une partie des bits, tout en laissant les autres intacts. Encore une fois, cela peut se faire facilement en utilisant une instruction bit à bit entre ce nombre et une constante bien choisie.

Supposons que le développeur veuille récupérer le jour stocké dans cette date. Comment doit-il s'y prendre ? Rien de plus simple : il suffit de mettre tous les autres bits du nombre à zéro, et de décaler le tout pour placer le résultat sur le bit de poids faible. Il suffit juste de choisir le bon décalage, et la bonne constante. Toutefois, cette méthode a un défaut : les constantes utilisées sont souvent très longues, ce qui empêche d'utiliser le mode d'adressage immédiat pour celles-ci. Raccourcir ces constantes permet de gagner pas mal de place. On peut ruser un petit peu en effectuant le décalage avant la mise à zéro.

Le cas le plus simple est quand le développeur souhaite récupérer un seul bit. Par exemple, si je veux récupérer le 5 éme bit en partant de la droite dans le nombre 1111 0011. Il me suffit de mettre tous les bits à zéro, sauf le bit voulu. Pour cela, je dois effectuer un AND entre 1111 0011 et la constante 0001 0000. J'obtiens alors 0001 0000. Ensuite, un décalage logique de 4 rangs vers la droite me donnera le bit voulu : 0000 0001. Autre exemple : je décale mon nombre 1111 0011 de 4 rangs vers la droite. J'obtiens 0000 1111. Ensuite, je mets tous les bits à zéro, sauf le bit de poids faible. La constante à utiliser est alors 0000 0001. Dans cette situation, on remarque que la constante à utiliser est très courte : c'est 1. Cette constante est très courte, ce qui permet d'utiliser le mode d'adressage immédiat pour l'instruction AND. De quoi gagner quelques cycles.

Le poids de Hamming

Il arrive qu'on ait besoin de compter les bits d'un certain nombre. Par exemple, certaines application en cryptographie ont besoin de savoir combien de bits sont à 1 dans un nombre. Même chose pour la détection ou correction d'erreurs de transmission entre deux composants électroniques. Certaines de ces opérations, comme le poids de Hamming, se calculent fort bien avec des opérations bit à bit. Le poids de Hamming d'un nombre est le nombre de ses bits qui sont à 1. Ce calcul est souvent effectué quand on cherche à vérifier l'intégrité de données transmises ou stockées sur un support peu fiable et il est à la base d'un grand nombre de code de détection ou de correction d'erreurs usuels. Ce calcul est tellement fréquent que certains processeur disposent d'une instruction dédiée pour le calcul du poids de Hamming. Alors certes, ces architectures sont surtout des architectures anciennes, comme les SPARC, les CDC ou autres processeurs Cray. Mais à l'heure actuelle, les processeurs x86 possèdent une telle instruction, dans leurs extension SSE 4.1. Même chose pour les architectures ARM et Power PC. Ce calcul, s'il n'est pas effectué par le matériel, est pris en charge par un bout de code souvent rudimentaire. Si quelques compilateurs fournissent ainsi des opérateurs spécialisés pour faire ce calcul, le poids de Hamming n'est pas implémenté par la plupart des langages de programmation. Il faut dire que son utilisation essentiellement bas-niveau fait que la majorité des langages de haut-niveau actuel n'en a pas l'utilité.

Méthode itérative

[modifier | modifier le wikicode]Pour faire ce calcul, on pourrait penser naïvement à utiliser une simple boucle pour additionner les bits un par un. Le nombre d'itération est alors égal au nombre de bits du nombre, peu importe le nombre de 1. Le code, écrit en C, devrait être le suivant, pour un entier 32 bits :

unsigned HammingWeight (unsigned x)

{

unsigned HammingWeight = 0 ;

while (x > 0)

{

HammingWeight += x & 1 ;

x = x >> 1 ;

}

return HammingWeight ;

}

Une autre version, un peu plus rapide, se base sur une boucle similaire. Elle consiste à mettre à 0 le 1 de poids faible (celui le plus à droite) à chaque tour de boucle. Pour cela, il suffit d'appliquer l'expression , dont on expliquera le fonctionnement dans quelques chapitres. En faisant cela, à chaque itération, le poids de Hamming diminue donc de 1. Il suffit de compter le nombre d'itération avant d'arriver à 0 pour déterminer le poids de Hamming. Le nombre d'itération est alors plus faible qu'avec le code précédent : le nombre d'itération passe du nombre de bits total au nombre de bits à 1. Le nombre d’itérations dans le pire des cas est alors le même qu'avec le code précédent, mais le nombre moyen ou dans le meilleur des cas diminue fortement. Le code obtenu est alors le suivant :

unsigned HammingWeight (unsigned x)

{

unsigned HammingWeight = 0 ;

while (x > 0)

{

x = x & (x - 1) ;

HammingWeight += 1 ;

}

return HammingWeight ;

}

Méthode par pré-calcul

[modifier | modifier le wikicode]On peut aussi faire le calcul octet par octet. Pour cela, il suffit d'utiliser un tableau où la case d'indice i contient le poids de Hamming de i. Il suffit ensuite d'utiliser ce tableau dans une boucle pour faire l'addition octet par octet. On peut même dérouler totalement la boucle, si l'on connait exactement le nombre d'octets de l'entier à traiter. Cette technique a cependant le défaut d'effectuer des accès à la mémoire, qui sont des opérations assez lentes.

unsigned HammingWeight (unsigned x)

{

static char table[256] = { 0, 1, 1, 2, 1, 2, 2, ... , 5, 5, 6, 5, 6, 6, 7, 5, 6, 6, 7, 6, 7, 7, 8 } ; // Tableau qui contient les poids de Hamming de chaque octet

FirstByte = x & 0xFF ;

SecondByte = (x >> 8) & 0xFF ;

ThirdByte = (x >> 16) & 0xFF

ForthByte = (x >> 24) & 0xFF

return table[FirstByte] + table[SecondByte] + table[ThirdByte] + table[ForthByte] ;

}

Méthode récursive (diviser pour régner)

[modifier | modifier le wikicode]

Une autre solution effectue ce calcul avec une fonction récursive, avec une approche par dichotomie. En découpant un nombre en deux morceaux, on sait que son poids de Hamming est égal à la somme des poids de Hamming des deux morceaux. Et le même raisonnement s'applique sur chaque morceau. Au final, les morceaux sont de plus en plus petits, jusqu'à obtenir des morceaux de 1 bit. Dans ce cas, je sais que la population count d'un morceau de 1 bit vaut 1 si le bit est à 1, et zéro s'il vaut zéro. En clair : la population count de 1 bit vaut… le bit en question. Cela signifie qu'il suffit d'additionner tous les bits du nombre pour obtenir le nombre de uns. Dans les deux cas, le code devrait donc faire le calcul en N cycles, N étant le nombre de bits du nombre. Mais il y a moyen de faire beaucoup plus rapide, avec un calcul en log(N) opérations ! Pour cela, il faut utiliser une méthode qui s'inspire de la méthode récursive, mais utilise des opérations bit à bit pour faire certains calculs en parallèle. La méthode en question est, à mon avis, le plus beau algorithme utilisant des opérations bit à bit au monde.

L’algorithme

[modifier | modifier le wikicode]Pour illustrer l'algorithme, nous allons prendre l'exemple d'un nombre sur 8 bits que nous noterons N. L'algorithme commence par grouper les bits du nombre par groupes de deux et les additionne dans deux variables. La première variable va stocker tous les bits à une position paire, les autres bits étant mis à zéro (...0x0x0x0x0x). L'autre variable va faire la même chose avec les bits en position impaire, mais décalé d'un rang vers la droite, histoire que les bits des deux variables soient sur la même colonne (...0x0x0x0x0x également). Les deux variables sont alors additionnées : variable 1 + variable2 >> 1.

La première étape effectue donc le calcul suivant :

- variable1 = N . 01010101

- variable2 = (N . 10101010) >> 1

- variable 1 + variable 2.

Au niveau de chaque paire de bits (00 ou 01) l'addition de la paire en position paire avec celle en position impaire donne le nombre de bits à 1 sans report de retenue au delà de la paire de bits.

Regardons en détail ce qui se passe sur les bits de N.

| Variable | groupe de deux bits | groupe de deux bits | groupe de deux bits | groupe de deux bits |

|---|---|---|---|---|

| Nombre N | a7 a6 | a5 a4 | a3 a2 | a1 a0 |

| Variable1 0 a6 0 a4 0 a2 0 a0 | 0 a6 | 0 a4 | 0 a2 | 0 a0 |

| Variable 2 >> 1 | 0 a7 | 0 a5 | 0 a3 | 0 a1 |

| Variable 1 + Variable 2 >> 1 | (a7 + a6) | (a5 + a4) | (a3 + a2) | (a1 + a0) |

La seconde étape est similaire, si ce n'est qu'elle isole les groupes de deux bits créés à l'étape précédente deux à deux, et les additionne.

| Variable | groupe de quatre bits | groupe de quatre bits |

|---|---|---|

| Opérande | (a7 + a6) (a5 + a4) | (a3 + a2) (a1 + a0) |

| Variable1 | (a7 + a6) 00 | (a3 + a2) 00 |

| Variable 2 >> 2 | 00 (a5 + a4) | 00 (a1 + a0) |

| Variable 1 + Variable 2 >> 2 | (a7 + a6 + a5 + a4) | (a3 + a2 + a1 + a0) |

Et on, poursuit ainsi de suite, jusqu'à obtenir la population count de notre nombre. Dans notre exemple, une troisième étape suffit pour obtenir le résultat.

| Variable | groupe de huit bits |

|---|---|

| Opérande | (a7 + a6 + a5 + a4) (a3 + a2 + a1 + a0) |

| Variable1 | 0000 (a7 + a6 + a5 + a4) |

| Variable 2 >> 4 | 0000 (a3 + a2 + a1 + a0) |

| Variable 1 + Variable 2 >> 4 | (a7 + a6 + a5 + a4 + a3 + a2 + a1 + a0) |

Détermination des masques

[modifier | modifier le wikicode]L'algorithme commence par calculer des variables avec des groupes de bits en position paire et impaire, le reste des bits étant mis à 0. Il est évident que cela demande d'utiliser des masques pour mettre les bits inutiles à zéro. Dans le cas de la seconde variable, les bits doivent être décalés histoire d'être mis sur la même colonne que l'autre variable. On peut penser qu'il est naturel d'appliquer les masques avant des décalages, ce qui donne : variable1 = N . 01010101 et variable2 = N . 10101010. Dans ce cas, le calcul de variable2 et de variable1 ne s'effectuent pas avec les mêmes constantes. Ceci dit, il est aussi possible de faire le décalage de la seconde variable avant d'appliquer le masque. Dans ce cas, les masques des deux variables deviennent identiques. Pour le montrer, partons des calculs où le masque est appliqué avant le décalage :

- variable2 = (N . 10101010) >> 1

- variable2 = (N . 11001100) >> 2

- variable2 = (N . 11110000) >> 4

Vu que les décalages sont distributifs par rapport au AND, (a . b) >> n = (a >> n) . (b >> n), on obtient :

- variable2 = (N >> 1) . (10101010 >>1) = (N >> 1) . 01010101

- variable2 = (N >> 2) . (11001100 >>2) = (N >> 2) . 00110011

- variable2 = (N >> 3) . (11110000 >>4) = (N >> 3) . 00001111

Les constantes utilisées sont exactement les mêmes que celles utilisée dans le calcul de la première variable.

Cela a un avantage sur certaines architectures RISC où les constantes immédiates ont une taille limitée. En conséquence, si une constante dépasse cette taille, elle ne peut pas utiliser le mode d'adressage immédiat. À la place, la constante est placée dans la mémoire, et est chargée dans un registre à chaque utilisation. Le fait de réutiliser la même constante pour le calcul de variable1 et de variable2 permet ainsi de charger cette constante une seule fois, et la réutiliser depuis le registre lors du calcul de variable2. En utilisant deux constantes différentes, on aurait deux accès mémoire, ce qui aurait été bien plus lent.

Le code en C

[modifier | modifier le wikicode]Fort de ce qui a été dit précédemment, on trouve que le code de calcul du poids de Hamming est le suivant pour un entier de 32 bits :

unsigned HammingWeight (unsigned x)

{

x = (x & 0x55555555) + ((x >> 1) & 0x55555555);

x = (x & 0x33333333) + ((x >> 2) & 0x33333333);

x = (x & 0x0F0F0F0F) + ((x >> 4) & 0x0F0F0F0F);

x = (x & 0x00FF00FF) + ((x >> 8) & 0x00FF00FF);

x = (x & 0x0000FFFF) + ((x >> 16) & 0x0000FFFF);

return x ;

}

Il est possible de simplifier encore plus ce code, en supprimant quelques ET.

unsigned HammingWeight (unsigned x)

{

x = x - ((x >> 1) & 0x55555555);

x = (x & 0x33333333) + ((x >> 2) & 0x33333333);

x = (x + (x >> 4)) & 0x0F0F0F0F;

x = x + (x >> 8);

x = x + (x >> 16);

return x & 0x0000003F;

}

Bit de parité

Les données d'un ordinateur ne sont pas des plus sûres qui soit. Évidemment, ces données peuvent être corrompues par un tiers malveillant, contenir des virus, etc. Mais certaines données sont corrompues pour des raisons qui ne relèvent pas de la volonté de nuire. Par exemple, les transmissions de données via un réseau local ou internet peuvent subir des perturbations électromagnétiques entre leur envoi et leur réception. Évidemment, les câbles réseaux sont conçus pour limiter les erreurs, mais ils ne sont pas une protection magique, capable de supprimer les erreurs de transmission. Dans le même genre, les mémoires ne sont pas des dispositifs parfaits, capables de fonctionner sans erreur. Pour donner un exemple, on peut citer l'incident de Schaerbeek. Le 18 mai 2003, dans la petite ville belge de Schaerbeek, une défaillance temporaire d'une mémoire faussa les résultats d'une élection. Cette ville utilisait une machine à voter électronique, qui contenait donc forcément une mémoire. Et on constata un écart de 4096 voix en faveur d'un candidat entre le dépouillement traditionnel et le dépouillement électronique. Mais ce n'était pas une fraude : le coupable était un rayon cosmique, qui avait modifié l'état d'un bit de la mémoire de la machine à voter. Cet incident n'était pas trop grave : après tout, il a pu corriger l'erreur. Mais imaginez la même défaillance dans un système de pilotage en haute altitude... Mais qu'on se rassure : il existe des techniques pour détecter et corriger les erreurs de transmission, ou les modifications non-prévues de données. Pour cela, divers codes de détection et de correction d'erreur ont vu le jour. Ce chapitre vous parlera du code le plus simple qui soit : le bit de parité/imparité, et de ses variantes.

Bit de parité horizontal mono-dimensionnel

[modifier | modifier le wikicode]Le bit de parité est une technique utilisée dans un grand nombre de circuits électroniques, comme certaines mémoires RAM, ou certains bus (RS232, notamment). Il permet de détecter des corruptions qui touchent un nombre impair de bits. Si un nombre pair de bit est modifié, il sera impossible de détecter l'erreur avec un bit de parité. Il faut noter que ce bit de parité, utilisé seul, ne permet pas de localiser le bit corrompu. Ce bit de parité est ajouté aux bits à stocker. Avec ce bit de parité, le nombre stocké (bit de parité inclus) contient toujours un nombre pair de bits à 1. Ainsi, le bit de parité vaut 0 si le nombre contient déjà un nombre pair de 1, et 1 si le nombre de 1 est impair. Si un bit s'inverse, quelle qu'en soit la raison, la parité du nombre total de 1 est modifié : ce nombre deviendra impair si un bit est modifié. Et ce qui est valable avec un bit l'est aussi pour 3, 5, 7, et pour tout nombre impair de bits modifiés. Mais tout change si un nombre pair de bit est modifié : la parité ne changera pas. Ainsi, on peut vérifier si un bit (ou un nombre impair) a été modifié : il suffit de vérifier si le nombre de 1 est impair. Le bit d'imparité est similaire a bit de parité, si ce n'est que le nombre total de bits doit être impair, et non pair comme avec un bit de parité. Sa valeur est l'inverse du bit de parité du nombre : quand le premier vaut 1, le second vaut 0, et réciproquement. Mais celui-ci n'est pas meilleur que le bit de parité : on retrouve l'impossibilité de détecter une erreur qui corrompt un nombre pair de bits.

Reste que ce bit de parité doit être calculé, avec un morceau de code dédié qui prend un nombre et renvoie le bit de parité.

Poids de Hamming et bit de parité

[modifier | modifier le wikicode]Par définition, le bit de parité n'est autre que la parité du poids de Hamming. Par définition, le bit de parité a pour but de faire en sorte que la population count d'une donnée soit toujours pair : la donnée à laquelle on ajoute le bit de parité sera pair, et aura toujours son bit de poids faible à zéro. En conséquence, le bit de parité d'un nombre est égal au bit de poids faible de la population count d'un nombre. Et cette propriété permet de donner des algorithmes de calcul du bit de parité d'un nombre assez efficace. Son calcul demande donc simplement de calculer le poids de Hamming et de déterminer s'il est pair ou non. Vu que le calcul du poids de Hamming a une complexité logarithmique en le nombre de bits de la donnée d'entrée, le code qui va suivre sera aussi dans ce cas. Cet algorithme est parfois utilisé sur des systèmes qui ont peu de mémoire, quand on a déjà programmé une fonction pour le poids de Hamming : cela permet d'économiser un peu de mémoire programme. Mais cet algorithme n'est pas le plus efficace en terme de temps de calcul.

unsigned population_count (unsigned word) ;

unsigned parity_bit (unsigned word)

{

return population_count (word) & 1 ;

}

Il est cependant possible d'obtenir un code plus simple, qui est plus rapide. Pour cela, il suffit de spécialiser le code pour le poids de Hamming, de manière à ce qu'il calcule uniquement le bit de parité. En conséquence, la suite de cette partie se contentera de reprendre les algorithmes pour calculer le code de Hamming et de les adapter pour le bit de parité.

Algorithme itératif

[modifier | modifier le wikicode]Nous allons commencer par adapter le code itératif du calcul du poids de Hamming. Pour faire simple, la structure générale du code est conservée, mais il nous faudra remplacer les additions par une autre opération. Pour savoir quelle est cette opération, nous allons voir un cas simple : le calcul de la parité d'un nombre de 2 bits. Le circuit étant simple, il suffit d'utiliser les techniques vues précédemment, avec la table de vérité. En écrivant la table de vérité du calcul, on remarque rapidement que la table de vérité est celle d'une porte XOR.

| Bit 1 | Bit 2 | Bit de parité |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 1 |

| 1 | 0 | 1 |

| 1 | 1 | 0 |

Pour la suite, nous allons rajouter un troisième bit au nombre de 2 bits précédent. L'ajout de ce troisième bit modifie naturellement le bit de parité du nombre précédent. Dans ce qui va suivre, nous allons voir comment calculer le bit de parité final, à partir : du bit de parité du nombre de 2 bits, et du bit ajouté. On voit alors que la table de vérité est celle d'une porte XOR.

| Bit de parité précédent | Bit ajouté | Bit de parité final |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 1 |

| 1 | 0 | 1 |

| 1 | 1 | 0 |

Chose assez intéressante, ce mécanisme fonctionne quel que soit le nombre de bits du nombre auquel on ajoute un bit. Ajouter un bit à un nombre modifie sa parité, celle-ci état alors égale à : bit ajouté XOR bit-parité du nombre. L’explication est relativement simple : ajouter n 0 ne modifie pas le nombre de 1, et donc le bit de parité, tandis qu'ajouter un 1 inverse le bit de parité. Ainsi, on déduit que le bit de parité peut se calculer simplement : il suffit de faire un XOR entre tous les bits du nombre. Effectué naïvement, il suffit d'enchainer des portes XOR les unes à la suite des autres. Mais en réfléchissant, on peut faire autrement. Prenons deux nombres et concaténons-les. On peut déduire facilement le bit de parité de la concaténation à partir des bits de parité de chaque nombre : il suffit de faire un XOR entre ces deux bits de parité.

Il suffit donc de faire un XOR de tous les bits pour calculer le bit de parité d'un nombre. L’algorithme de calcul du nombre de parité est alors assez évident.

unsigned parity_bit (unsigned word ,unsigned size)

{

unsigned parity_bit = 0 ;

// on itère sur chaque bit du mot à traiter

for(unsigned index = 0 ; index < size ; ++index)

{

//sélection du bit de poids faible

unsigned temp = word & 1

word = word >> 1 ;

// XOR entre le bit sélectionné et le bit de parité des bits précédents.

parity_bit = parity_bit ^ temp ;

}

return parity_bit ;

}

Cette solution a un temps de calcul qui est linéaire en le nombre de bits de la donnée dont on veut calculer le bit de parité. On peut faire mieux en utilisant d'autres propriétés du bit de parité. Naturellement, on peut travailler non sur des bits, mais aussi sur des octets. Prenons un mot de 16 bits, par exemple : il me suffit de faire un XOR entre les bits de parité de ces deux octets. Or, la parité d'un octet peut se pré-calculer et être stockée dans un tableau une fois pour toute, afin d'éviter de nombreux calculs. Ainsi, l'algorithme vu précédemment peut être amélioré pour traiter non pas un bit à la fois, mais plusieurs bits à la fois.

unsigned ParityBit (unsigned x)

{

static char table[256] = { 0, 1, 0, 1, 0, 1, 0, 1, 0, 1, 0, 1, 0, 1, ... , 0, 1, 0, 1, 0, 1, 0, 1, 0, 1,} ; // Tableau qui contient les bits de parité de chaque octet

FirstByte = x & 0xFF ;

SecondByte = (x >> 8) & 0xFF ;

ThirdByte = (x >> 16) & 0xFF

ForthByte = (x >> 24) & 0xFF

return table[FirstByte] ^ table[SecondByte] ^ table[ThirdByte] ^ table[ForthByte] ;

}

Algorithme récursif

[modifier | modifier le wikicode]On peut améliorer l'algorithme du dessus en utilisant la propriété suivante : si on concatène deux mots binaire, alors le bit de parité du mot obtenu est égal au XOR des bits de parité des deux mots concaténés. Cette propriété peut s'expliquer assez simplement. Pour cela, il suffit de regarder le nombre de bits à 1 dans chaque mot à concaténer.

| Nombre de bits à 1 dans le mot binaire de gauche | Nombre de bits à 1 dans le mot binaire de droite | Nombre de bits à 1 dans le résultat |

|---|---|---|

| Pair | Pair | Pair |

| Pair | Impair | Impair |

| Impair | Pair | Impair |

| Impair | Impair | Pair |

Si on remplace Pair et Impair par la valeur du bit de parité correspondant, on obtient exactement le fonctionnement d'une porte XOR.

On peut aussi inventer un autre algorithme du calcul du bit de parité, assez inefficace, basé sur une fonction récursive. Le principe est de couper le mot dont on veut la parité en deux morceaux. On calcule alors la parité de ces deux morceau, et on fait un XOR entre ces deux parités. Le code obtenu est alors celui-ci :

unsigned parity (unsigned word, size)

{

if (word <= 1)

{

return word ;

}

else

{

unsigned gauche = word >> (size/2) ;

unsigned droite = word % (size/2) ;

return parity(gauche, size/2) ^ parity (droite, size/2)) ;

}

}

Algorithme optimisé

[modifier | modifier le wikicode]Il est aussi possible de réutiliser l'algorithme de calcul du poids de Hamming, celui récursif basé sur des masques et des additions, pour calculer le bit de parité. La différence est que les bits ne doivent pas être additionnés, mais XORés. Fort de ce qui a été dit précédemment, on trouve que le code de calcul du bit de parité est le suivant pour un entier de 32 bits :

unsigned ParityBit (unsigned x)

{

x = (x & 0x55555555) ^ ((x >> 1) & 0x55555555);

x = (x & 0x33333333) ^ ((x >> 2) & 0x33333333);

x = (x & 0x0F0F0F0F) ^ ((x >> 4) & 0x0F0F0F0F);

x = (x & 0x00FF00FF) ^ ((x >> 8) & 0x00FF00FF);

x = (x & 0x0000FFFF) ^ ((x >> 16) & 0x0000FFFF);

return x ;

}

Il faut noter que cet algorithme est cependant simplifiable pour le calcul du bit de parité. L'usage des masques permet de XOR les bits de position paire et impaire, puis des groupes consécutifs de 2 bits, puis de 4 bits, etc. Mais pour le bit de parité, on peut effectuer le calcul dans l'autre sens. Pour des entiers de 64 bits, on peut commencer par XOR les 32 bits de poids fort avec les 32 bits de poids faible. Plus, sur les 32 bits du résultat, on peut XOR les 16 bits de poids fort et les 16 de poids faible. Et ainsi de suite... L'algorithme est donc plus simple, vu que l'on a pas besoin d'utiliser des masques, mais que l'on peut se contenter de décalages. Le code est donc le suivant :

unsigned ParityBit (unsigned x)

{

x ^= (x >> 32) ;

x ^= (x >> 16) ;

x ^= (x >> 8) ;

x ^= (x >> 4) ;

x ^= (x >> 2) ;

x ^= (x >> 1) ;

return x & 1 ;

}

Mot de parité

[modifier | modifier le wikicode]Si on peut calculer le bit de parité d'un mot, il est aussi possible de calculer des octets de parité pour un ensemble de Byte/mots machine. Le résultat de cette opération est ce qu'on appelle un mot de parité, une extension du bit de parité pour plusieurs nombres. On peut le voir comme l'équivalent d'un bit de parité pour un paquet de nombre. Cela sert sur les bus de communication entre composants, sur lesquels on peut envoyer plusieurs nombres à la suite, ou dans les mémoires qui stockent plusieurs nombres les uns à côté des autres. Il faut noter que le bit de parité peut être vu comme une spécialisation de la technique du mot de parité, où les blocs font tous 1 bit. Le calcul du mot de parité se calcule en disposant chaque nombre/bloc l'un au-dessus des autres, le tout donnant un tableau dont les lignes sont des nombres Le mot de parité se calcul en calculant le bit de parité de chaque colonne du tableau, et en le plaçant en bas de la colonne. Le résultat obtenu sur la dernière ligne est un octet de parité. Pour comprendre le principe, supposons que nous disposions de 8 entiers de 8 bits. Voici comment effectuer le calcul du mot de parité :

- 11000010 : nombre ;

- 10001000 : nombre ;

- 01001010 : nombre ;

- 10010000 : nombre ;

- 10001001 : nombre ;

- 10010001 : nombre ;

- 01000001 : nombre ;

- 01100101 : nombre ;

- ------------------------------------

- 10101100 : mot de parité.

L'avantage de cette technique est qu'elle permet de reconstituer un octet manquant. C'est cette technique qui est utilisée sur les disques durs montés en RAID 3, 5 6, et autres : si un disque dur ne fonctionne plus, on peut quand même reconstituer les données du disque dur manquant. Retrouver la donnée manquante est assez simple : il suffit de calculer la parité des nombres restants et de faire un XOR avec le mot de parité. Pour comprendre pourquoi cela fonctionne, il faut se souvenir que faire un XOR entre un nombre et lui-même donne 0. De plus, le mot de parité est égal au XOR de tous les nombres. Si on XOR un nombre avec le mot de parité, cela va annuler la présence de ce nombre (son XOR) dans le mot de parité : le résultat correspondra au mot de parité des nombres, nombre xoré exclu. Ce faisant, en faisant un XOR avec tous les nombres connus, ceux-ci disparaitrons du mot de parité, ne laissant que le nombre manquant.

Bit de parité multidimensionnel

[modifier | modifier le wikicode]On a vu que le bit de parité ne permet pas de savoir quel bit d'un nombre a été modifié. Mais il existe une solution pour que cela devienne possible, dans le cas où plusieurs nombres sont envoyés. Si on suppose qu'un seul bit a été modifié lors de la transmission du paquet de nombre, on peut détecter quel bit exact a été modifié. Pour cela, il suffit de coupler un mot de parité avec plusieurs bits de parité, un par nombre. Détecter l bit modifié est simple. Pour comprendre comment, il faut se souvenir que les nombres sont organisés en tableau, avec un nombre par ligne. Le bit modifié est situé à l'intersection d'une ligne et d'une colonne. Sa modification entraînera la modification du bit de parité de la ligne et de la colonne qui correspondent, respectivement un bit de parité sur la verticale, et un bit de parité dans le mot de parité. Les deux bits fautifs indiquent alors respectivement la ligne et la colonne fautive, le bit erroné est situé à l'intersection. Cette technique peut s'adapter non pas avec une disposition en lignes et colonnes, mais aussi avec des dimensions en plus où les nombres sont disposés en cube, en hyper-cube, etc.

Manipulations sur les bits de poids faible/fort

Dans cette section, nous allons voir comment effectuer certaines opérations qui manipulent certains bits de poids fort ou certains bits de poids faible. Mais avant de commencer, un petit point sur la terminologie de ce chapitre. Nous aurons à utiliser des expressions du type "le 1 de poids faible", "les 0 de poids faible" et quelques autres du même genre. Quand nous parlerons du 0 de poids faible, nous voudrons parler du premier 0 que l'on croise dans un nombre en partant de sa droite. Par exemple, dans le nombre 0011 1011, le 0 de poids faible est le troisième bit en partant de la droite. Quand nous parlerons du 1 de poids faible, c'est la même chose, mais pour le premier bit à 1. Par exemple, dans le nombre 0110 1000, le 1 de poids faible est le quatrième bit. Quant aux expressions "le 1 de poids fort" et "les 0 de poids fort" elles sont identiques aux précédentes, sauf qu'on parcourt le nombre à partir de sa gauche.

Par contre, les expressions "les 1 de poids faible" ou "les 0 de poids faible" ne parlent pas de la même chose. Quand nous voudrons parler des 1 de poids faible, au pluriel, nous voulons dire : tous les bits situés avant le 0 de poids faible. Par exemple, prenons le nombre 0011 0011 : les 1 de poids faible correspondent ici aux deux premiers bits en partant de la gauche. Même chose quand on parle des zéros de poids faible au pluriel. Quant aux expressions "les 1 de poids fort" ou "les 0 de poids fort" elles sont identiques aux précédentes, sauf qu'on parcourt le nombre à partir de sa gauche.

Avant de poursuivre, rappelons quelques trivias.

- La valeur maximale codable sur n bits, , est encodée par un nombre dont tous les bits sont à 1.

- Les nombres de la forme 000...000 1111 1111, à savoir des nombres dont les x bits de poids faible sont à 1 et tous les autres valent 0, valent .

- Les nombres de la forme 11111...0000 (où on a une suite consécutive de 1 dans les bits de poids fort et les x bits de poids faibles à 1) valent : .

Le schéma ci-dessus montre que l'on peut obtenir le troisième nombre en soustrayant les deux précédents. Ce qui permet de rapidement démontrer le troisième trivia.

Manipuler les bits de poids fort/faible avec un masque

[modifier | modifier le wikicode]Il y a quelques chapitres, nous avons vu que les masques permettent de remplacer certains bits d'un nombre soit par des 0, soit par des 1. Dans ce qui va suivre, nous allons voir ce qui se passe quand on fait cela soit pour les bits de poids fort, soit pour ceux de poids faible. Par bits de poids fort/faible, nous ne voulons pas parler d'un bit précis, mais des bits de poids faible/fort, le nombre pouvant être choisit arbitrairement. En tout, cela fait quatre possibilités :

- remplacer les bits de poids faible par des zéros ;

- remplacer les bits de poids faible par des 1;

- remplacer les bits de poids fort par des zéros;

- remplacer les bits de poids fort par des 1.

La dernière possibilité ne nous intéressera pas, parce qu'elle ne correspond pas à une opération utile. Par contre, les trois autres possibilités correspondent à des opérations utiles, surtout la troisième. Pour faire ces opérations, nous aurons besoin d'utiliser des masques pour sélectionner les bits de poids faible/fort. Pour cela, il faut utiliser un masque, comme nous l'avons vu dans les chapitres précédents. Le masque qui permet de sélectionner les bits de poids faible a ses bits de poids faible à 1 et les autres à zéro, ce qui fait qu'il est égal à . Celui pour les sélectionner les bits de poids fort est l'inverse de ce masque. Par inverse du masque, on veut dire que les bits à 0 passent à 1 et réciproquement. Sous forme mathématique, cela donne :

- Pour mettre les n bits de poids faible à 1, l'opération à effectuer est un OU entre le masque et le nombre à masquer. Sous forme mathématique, cela donne :

- , le étant ici un OU logique.

- Pour sélectionner les n bits de poids faible et mettre les autres à zéro, l'opération est un ET entre le masque et le nombre.

- , le étant ici un ET logique.

- Pour mettre les n bits de poids faible à 0, il faut faire un ET avec l'inverse du masque.

- Sur les ordinateurs qui utilisent le complètement à deux pour coder les nombres signés, cette expression se simplifie en :

Les trois opérations donnent des résultats très différents, mais qui peuvent se comprendre assez facilement quand on connait les rudiments de la division. Et pour mieux comprendre, le mieux est de regarder ce qui se passe quand on effectue les opérations équivalentes en décimal. Les opérations équivalentes consistent à remplacer certains chiffres par des 0 ou par des 9. Par exemple, mettre à zéro les bits de poids faible revient en décimal à mettre à zéro les N derniers chiffres. Mettre à 1 les bits de poids faible revient en décimal à remplacer les n derniers chiffres par des 9. Et idem pour les bits de poids fort.

Manipuler les bits de poids fort : le calcul du modulo

[modifier | modifier le wikicode]Comme dit plus haut, les puissances de 10 ont en décimal le même rôle que les puissances de deux en binaire. Une division décimale par 10, 100, 1000, est en quelque sorte la même chose qu'une division binaire par 2, 4, 8. Or, la division décimale et le modulo décimal sont très simples avec les puissances de 10. Diviser par 10 demande juste d'éliminer le dernier chiffre, diviser par 100 demande d'éliminer les deux derniers chiffres, diviser par 1000 demande d'éliminer les trois derniers chiffres, etc. De manière générale, diviser par demande d'éliminer les derniers chiffres. Pour le modulo, c'est la même chose. Le reste d'une division par 10 demande de conserver le dernier chiffre, à savoir le chiffre qui serait effacé par la division par 10. De même, le modulo par 100 demande de conserver juste les deux derniers chiffres, le modulo par 1000 demande de conserver les trois derniers chiffres, le modulo par 10000 les quatre derniers chiffres, etc.

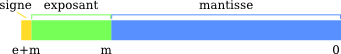

En binaire, c'est la même chose, sauf que les chiffres sont ici les bits. En clair, il faut éliminer les n derniers bits pour obtenir le quotient, les conserver pour trouver le modulo. Le résultat d'une division binaire par est composé des bits de poids forts, ceux au-delà du rang . Le résultat du modulo par , quant à lui, est composé des bits de poids faible. Le tout est illustré dans le schéma ci-dessous.

On retrouve le fait qu'une division par se calcule en faisant un décalage vers la droite de n rangs. Et à l'opposé, on comprend ce qui se passe quand on masque les bits de poids fort, en les remplaçant par des zéros : on calcule le modulo par . Calculer le modulo par demande juste de garder les bits de poids faible. Pour comprendre pourquoi cela fonctionne, partons de l'écriture en binaire d'un nombre :

Par définition, le modulo d'un nombre prend le reste de la division par un entier, c’est-à-dire ce qu'il reste une fois qu'on a éliminé tous les multiples du quotient. Sachant que dans notre cas, le quotient est égal à , cela veut dire qu'on doit supprimer tous les multiples de dans l'écriture binaire de notre nombre, en les mettant à zéro. Et cela revient en fait à ne conserver que les n bits les plus à droite dans l'écriture binaire de notre nombre.

Manipuler les bits de poids faible : des arrondis liés à des multiples de

[modifier | modifier le wikicode]Maintenant, nous allons voir ce qui se passe quand on met les n bits de poids faible d'un nombre à 0 ou à 1. Ces bits correspondent au modulo par , ce qui fait que nous les appellerons tout bonnement : le modulo, sous-entendu le modulo à . Quand il sera fait mention de "mettre le modulo à 0", cela vaudra dire que tous les n bits de poids faible seront mis à 0. Et pour l'expression "mettre le modulo à sa valeur maximale", cela vaudra dire que tous les n bits de poids faible seront mis à 1.

Les deux opérations, à savoir mettre le modulo à zéro ou à 1, sont liés à des arrondis particuliers. Les arrondis en question arrondissent au multiple de immédiatement supérieur ou inférieur. Pour comprendre à quoi correspondent ces arrondis, prenons l'exemple du nombre 46, qu'on souhaite arrondir au multiple de 8 immédiatement supérieur/inférieur. Le fait est que 46 n'est pas un multiple de 8, mais est situé entre deux multiples de 8 : 48 (8*6) et 40 (8*5). Arrondir 46 au multiple de 8 immédiatement supérieur donne 46, alors qu'arrondir au multiple de immédiatement inférieur donne 40. La même logique peut s'appliquer pour les multiples de 4, 16, 32 et autres. Par exemple, reprenons le nombre 46 et arrondissons-le au multiple de 16 immédiatement supérieur/inférieur. Arrondir au multiple de 16 immédiatement inférieur donne 32 (16*2), alors qu'arrondir au multiple de 16 immédiatement supérieur 48 (16*3).

Dans ce qui va suivre, nous allons noter le nombre à arrondir. Le multiple de immédiatement inférieur sera noté , alors que le multiple immédiatement supérieur sera noté . On a alors :

Par définition, et sont des multiples de , et qui plus est deux multiples consécutifs. On a donc :

Cette inégalité sera très importante pour comprendre comment calculer les arrondis en question.

Mettre les bits de poids faible à zéro

[modifier | modifier le wikicode]Pour commencer, regardons ce qui se passe quand on met les bits de poids faible à zéro et essayons de donner un sens au résultat. L'idéal est de comparer avec ce qui se passe avec l'opération équivalente en décimal. Celle-ci revient, dans un nombre décimal, à remplacer les N derniers chiffres par des zéros. Par exemple, mettre le dernier chiffre à 0 revient à arrondir à la dizaine la plus proche, mettre les deux derniers chiffres à 0 revient à arrondir à la centaine la plus proche, mettre les trois derniers chiffres à 0 revient à arrondir au millier le plus proche, etc. En clair : remplacer les N derniers chiffres par des 0 revient à arrondir au multiple de immédiatement inférieur. En binaire, c'est la même chose, mais avec les bits et des puissances de 2.

Pour comprendre le sens du résultat, il faut revenir sur la division euclidienne de N par . Par définition de la division euclidienne, on a :

- , avec r le reste, qui est une constante inférieure à .

Rappelons que les n bits de poids faible d'un nombre sont le modulo par . Si l'on met le modulo par à zéro, cela revient à tout simplement soustraire le reste, le modulo proprement dit. On trouve :

Par définition, le terme de droite est le multiple de le plus proche de N, mais qui lui est immédiatement inférieur. Vous comprenez donc pourquoi je parle de ces arrondis particuliers juste après la section sur la division et le modulo par ! Tout cela pour dire que :

Mettre les bits de poids faible à 1

[modifier | modifier le wikicode]Maintenant, regardons ce qui se passe quand on met tous les bits du modulo non pas à zéro, mais à 1. En clair, le modulo est remplacé par la plus grande valeur qu'il peut prendre. Pour comprendre le sens du résultat de cette opération, repartons encore une fois de N écrit comme suit :

L'opération met le reste à sa valeur maximale, qui est composée de n bits tous à 1, qui est par définition égale à . Le remplacement donne donc un nombre tel que :

Pour comprendre le résultat, rappelons que l'on a : . En faisant le remplacement, on a :

En identifiant avec : , on trouve que le résultat est de :

En clair, mettre tous les n bits de poids fort d'un nombre à 1 donne le nombre qui est juste avant le multiple de immédiatement supérieur. Dit autrement, calculer le multiple de immédiatement supérieur demande de mettre les n bits de poids faible à 1 et d'incrémenter.

Manipuler les bits de poids faible, grâce à un incrément

[modifier | modifier le wikicode]Dans la section précédente, nous avons vu ce qu'il se passe quand on masque un nombre avec un nombre de la forme . Mais ce n'est pas la seule possibilité et d'autres masques peuvent être utilisés. Le cas le plus intéressant est d'utiliser un masque qui se calcule en incrémentant/décrémentant le nombre à masquer. Pour le dire plus clairement, nous allons étudier des calculs comme , , , etc. Pour comprendre comment ces formules fonctionnent, il faut voir en quoi un nombre et son suivant différent en binaire. Et pour cela, on doit parler de comment incrémenter un nombre en binaire avec seulement des opérations bit à bit.

Pour comprendre comment cela fonctionne, commençons d'abord par faire un rappel sur l'addition en binaire. La table d'addition est très simple en binaire. Jugez plutôt :

- 0 + 0 = 0, retenue = 0 ;

- 0 + 1 = 1, retenue = 0 ;

- 1 + 0 = 1, retenue = 0 ;

- 1 + 1 = 0, retenue = 1.

Évidemment, la retenue se propage au bit suivant, exactement comme en décimal.

Incrémenter un nombre revient à lui ajouter le nombre 000 ... 001, à savoir un nombre dont seul le bit de poids faible est à 1. En clair, incrémenter un nombre consiste juste à incrémenter le bit de poids faible et à propager les retenues. Regardons ce qui se passe quand on incrémente le bit de poids faible. S'il vaut 0, il passe alors à 1 et il n'y a pas de retenue à propager. Mais s'il vaut 1, il passe à 0 et une retenue est propagée sur la colonne suivante. Et si une retenue est propagée, la même chose se reproduit à la colonne suivante, et ainsi de suite... Au final, on voit que la propagation de la retenue s'arrête au premier bit à 0 rencontré, mais se propage tant que les bits de poids faible sont à 1.

Pour clarifier les choses, prenons un nombre de la forme suivante : XXXX ... XXXX 0111 ... 1111. Dans ce cas, l'incrémentation fait passer ce nombre de XXXX ... XXXX 0111 ... 1111 à XXXX ... XXXX 1000 ... 0000. Le premier zéro rencontré passe à 1, et tous les bits précédents passent à 0.

Notons que cette logique marche aussi s'il n'y a pas de 1 de poids faible : le bit de poids faible passe alors juste de 0 à 1.

Le seul cas un peu trompeur est celui où il n'y a pas de bit à zéro, dont l'incrémentation donne un débordement d'"entier. Mais dans ce cas, la gestion traditionnelle des débordement fait que le résultat est tout bonnement zéro.

| Nombre à incrémenter | Résultat de l'incrémentation |

|---|---|

| XXXX ... XXXX ... XXX0 | XXXX ... XXXX ... XXX1 |

| XXXX ... X011 ... 1111 | XXXX ... X100 ... 0000 |

| 1111 ... 1111 ... 1111 | 0000 ... 0000 ... 0000 |

Concrètement, les bits qui changent après incrémentation sont le 0 de poids faible et les bits précédents (les trailing ones).

En sachant ceci, vous pouvez facilement déterminer ce que donne le résultat de calculs comme , ou encore . Ces opérations vont donc modifier le 0 de poids faible et/ou les trailing ones.

Mettre à 0 les 1 de poids faible

[modifier | modifier le wikicode]Fort de ce qui vient d'être dit, regardons ce que fait l'opération suivante :

Reprenons le tableau précédent et regardons quel est le résultat de l’opération :

| XXXX ... XXXX ... XXX0 | XXXX ... X011 ... 1111 | 1111 ... 1111 ... 1111 | |

| XXXX ... XXXX ... XXX1 | XXXX ... X100 ... 0000 | 0000 ... 0000 ... 0000 | |

| XXXX ... XXXX ... XXX0 | XXXX ... X000 ... 000 | 0000 ... 0000 ... 0000 |

Si on analyse le résultat du tableau, on voit que la seule différence entre et est dans les bits de poids faible. Tous les bits de poids faible à 1, ceux situés avant le premier bit à 0, sont mis à 0.

Mettre à 1 le 0 de poids faible

[modifier | modifier le wikicode]Maintenant, regardons ce qui se passe si on remplace le ET par un OU.

Reprenons le tableau de l'incrémentation et regardons quel est le résultat de l’opération :

| XXXX ... XXXX ... XXX0 | XXXX ... X011 ... 1111 | 1111 ... 1111 ... 1111 | |

| XXXX ... XXXX ... XXX1 | XXXX ... X100 ... 0000 | 0000 ... 0000 ... 0000 | |

| XXXX ... XXXX ... XXX1 | XXXX ... X111 ... 1111 | 1111 ... 1111 ... 1111 |

On voit que cette opération permet de mettre à 1 le zéro de poids faible, à savoir le premier bit à 0 en partant des bits de poids faible.

Mettre à 0 les bits situés à gauche du 0 de poids faible

[modifier | modifier le wikicode]Maintenant, étudions le résultat de cette opération :

Ce calcul ressemble aux précédents, sauf que cette fois-ci, on a pris de NOT du résultat de l'incrémentation.

Reprenons le tableau des cas possibles. Précisons que pour un bit quelconque, noté X, son NOT sera noté Y.

| XXXX ... XXXX ... XXX0 | XXXX ... X011 ... 1111 | 1111 ... 1111 ... 1111 | |

| XXXX ... XXXX ... XXX1 | XXXX ... X100 ... 0000 | 0000 ... 0000 ... 0000 | |

| YYYY ... YYYY ... YYY0 | YYYY ... Y011 ... 1111 | 0000 ... 0000 ... 0001 | |

| 0000 ... 0000 ... 0000 | 0000 ... 0011 ... 1111 | 0000 ... 0000 ... 0001 |

Le tableau montre que ce calcul isole les 1 de poids faible. En clair, tous les bits situés à gauche du 0 de poids faible sont mis à 0.

Isoler le 0 de poids faible

[modifier | modifier le wikicode]Maintenant, étudions le résultat de cette opération, qui n'est autre que l'opération précédente dans laquelle on a remplacé le ET par un OU :

Reprenons le tableau des cas possibles. Précisons que pour un bit quelconque, noté X, son NOT sera noté Y.

| XXXX ... XXXX ... XXX0 | XXXX ... X011 ... 1111 | 1111 ... 1111 ... 1111 | |

| YYYY ... YYYY ... YYY0 | YYYY ... Y011 ... 1111 | 0000 ... 0000 ... 0001 | |

| 1111 ... 1111 ... 1110 | 1111 ... 1011 ... 1111 | 1111 ... 1111 ... 1111 |

On voit que tous les bits sont mis à 1, sauf un : le zéro le plus à droite, le zéro de poids faible. On dit que ce calcul isole le 0 de poids faible.

Isoler le 0 de poids faible et l'inverser

[modifier | modifier le wikicode]Maintenant, regardons ce que fait l'opération suivante :

Reprenons le tableau précédent et regardons quel est le résultat de l’opération :

| XXXX ... XXXX ... XXX0 | XXXX ... X011 ... 1111 | 1111 ... 1111 ... 1111 | |

| XXXX ... XXXX ... XXX1 | XXXX ... X100 ... 0000 | 0000 ... 0000 ... 0000 | |

| YYYY ... YYYY ... YYY1 | YYYY ... Y100 ... 0000 | 0000 ... 0000 ... 0000 | |

| 0000 ... 0000 ... 0001 | 0000 ... 0100 ... 000 | 0000 ... 0000 ... 0000 |

On voit que l'opération a pour un résultat un nombre dont le seul bit à 1 est situé à la position du zéro de poids faible de l'opérande.

Isoler les 1 de poids faible et inverser

[modifier | modifier le wikicode]Maintenant, regardons ce que fait l'opération suivante :

Reprenons le tableau précédent et regardons quel est le résultat de l’opération :

| XXXX ... XXXX ... XXX0 | XXXX ... X011 ... 1111 | 1111 ... 1111 ... 1111 | |

| XXXX ... XXXX ... XXX1 | XXXX ... X100 ... 0000 | 0000 ... 0000 ... 0000 | |

| YYYY ... YYYY ... YYY1 | YYYY ... Y100 ... 0000 | 0000 ... 0000 ... 0000 | |

| XXXX ... XXXX ... XXX1 | XXXX ... X100 ... 000 | 0000 ... 0000 ... 0000 |

On voit que cette opération isole les 1 de poids faible ceux situés avant le zéro de poids faible, mais inverse le résultat.

Manipuler les bits de poids faible/fort, grâce à un décrément

[modifier | modifier le wikicode]Maintenant, étudions ce qui se passe quand on décrémente un nombre. Il se passe alors la même chose qu'avec l'incrémentation, si ce n'est qu'on doit remplacer la table d'addition par la table de soustraction. Il y a toujours une retenue à propager d'une colonne vers la suivante, en partant du bit de poids faible. Par contre, la retenue est soustraite.

La table de soustraction est la suivante :

- 0 - 0 = 0, retenue = 0 ;

- 0 - 1 = 1, retenue = 1 ;

- 1 - 0 = 1, retenue = 0 ;

- 1 - 1 = 0, retenue = 0.

Décrémenter un nombre revient à lui soustraire le nombre 000 ... 001, à savoir un nombre dont seul le bit de poids faible est à 1. En clair, on soustrait 1 au bit de poids faible et on propage les retenues s'il y en a. La propagation de la retenue ne s'arrête cependant pas au même moment que la retenue d'une incrémentation. La raison est que la table de soustraction et d'addition sont différentes et que les cas où une retenue se propage ne sont pas les mêmes. Avec la décrémentation, la propagation de la retenue s'arrête au premier bit à 1 rencontré. Les bits avant ce premier 1 sont inversés et passent de 0 à 1. Si on reprend le tableau des trois cas possibles, voici ce que cela donne.

| Nombre à décrémenter | Résultat de la décrémentation |

|---|---|

| XXXX ... XXXX ... XXX1 | XXXX ... XXXX ... XXX0 |

| XXXX ... X100 ... 0000 | XXXX ... X011 ... 1111 |

| 0000 ... 0000 ... 0000 | 1111 ... 1111 ... 1111 |

Les bits qui changent après décrémentation sont le 1 de poids faible et les 0 précédents.

En sachant ceci, vous pouvez facilement déterminer ce que donne le résultat de calculs comme ou encore

Mettre à 0 le 1 de poids faible

[modifier | modifier le wikicode]Commençons par voir ce que donne ce calcul :

Le tableau des cas possibles donne ceci :

| XXXX ... XXXX ... XXX1 | XXXX ... X100 ... 0000 | 0000... 0000... 0000 | |

| XXXX ... XXXX ... XXX0 | XXXX ... X011 ... 1111 | 1111... 1111... 1111 | |

| XXXX ... XXXX ... XXX0 | XXXX ... X000 ... 0000 | 0000... 0000 ... 0000 |

On remarque que ce calcul ne change qu'un seul bit du nombre initial, pas un de plus, pas un de moins. Et ce bit, qui passe de 1 à 0, est le 1 le plus à droite dans l'écriture binaire, à savoir le 1 de poids faible.

| 1111 1111 | 1111 1110 |

| 1111 1110 | 1111 1100 |

| 1111 1000 | 1111 0000 |

| 0010 1000 | 0010 0000 |

| 0010 0000 | 0000 0000 |

Notons que ce calcul permet de vérifier si un nombre est une puissance de deux. Si ce calcul donne pour résultat zéro, alors le nombre est une puissance de deux. En effet, par définition, une puissance de deux n'a qu'un seul bit à 1. Si ce bit est mis à 0, alors on obtient bien un zéro.

Mettre à 1 le ou les 0 de poids faible

[modifier | modifier le wikicode]On peut maintenant se demander ce qui se passe quand on effectue non pas un ET, mais un OU, soit l'opération suivante :

Le tableau des cas possibles donne ceci :

| XXXX ... XXXX ... XXX1 | XXXX ... X100 ... 0000 | 0000... 0000... 0000 | |

| XXXX ... XXXX ... XXX0 | XXXX ... X011 ... 1111 | 1111... 1111... 1111 | |

| XXXX ... XXXX ... XXX1 | XXXX ... X111 ... 1111 | 1111... 1111... 1111 |

Dans ce cas, on remarque que les 0 de poids faibles sont mis à 1. Précisément, si on prend un nombre de la forme XXXXX...XXXX 100000...000, celui-ci devient de la forme XXXXX...XXXX 11111...1111. En clair, tous les bits qui se situe à droite du 1 de poids faible sont mis à 1. Par exemple, le nombre 0110 1010 0011 1000 deviendra 0110 1010 0011 1111.

Isoler le 1 de poids faible

[modifier | modifier le wikicode]A votre avis, que donne le résultat de cette opération :

Cela semble n'avoir aucun rapport avec les opérations précédentes, mais rappelez-vous des règles du complément à deux. Celles-ci disent que . En clair, ce calcul est équivalent au suivant :

On prend le tableau des différentes possibilités :

| XXXX ... XXXX ... XXX1 | XXXX ... X100 ... 0000 | 0000 ... 0000 ... 0000 | |

| XXXX ... XXXX ... XXX0 | XXXX ... X011 ... 1111 | 1111 ... 1111 ... 1111 | |

| YYYY ... YYYY ... YYY1 | YYYY ... Y100 ... 0000 | 0000 ... 0000 ... 0000 | |

| 0000 ... 0000... 0001 | 0000 ... 0100 ... 0000 | 0000 ... 0000 ... 0000 |

On voit que cette opération isole le 1 de poids faible, c'est à dire que le 1 de poids faible est conservé, tandis que tous les autres bits sont mis à zéro.

Isoler les 0 de poids faible

[modifier | modifier le wikicode]Reprenons l'opération précédente et remplacons le ET par un OU :

On prend le tableau des différentes possibilités :

| XXXX ... XXXX ... XXX1 | XXXX ... X100 ... 0000 | 0000 ... 0000 ... 0000 | |

| YYYY ... YYYY ... YYY1 | YYYY ... Y100 ... 0000 | 0000 ... 0000 ... 0000 | |

| 1111 ... 1111 ... 1111 | 1111 ... 1100 ... 0000 | 0000 ... 0000 ... 0000 |

On voit que cette opération isole les 0 de poids faible, c'est à dire les bits situés avant le 1 de poids faible. Tous les autres bits sont mis à 1.

Isoler les 0 de poids faible et inverser

[modifier | modifier le wikicode]Étudions maintenant ce calcul :

- ;

Le tableau des cas possibles donne ceci :

| XXXX ... XXXX ... XXX1 | XXXX ... X100 ... 0000 | 0000... 0000... 0000 | |

| YYYY ... YYYY ... YYY0 | YYYY ... Y011 ... 1111 | 1111 ... 1111 ... 1111 | |

| XXXX ... XXXX ... XXX0 | XXXX ... X011 ... 1111 | 1111... 1111... 1111 | |

| 0000... 0000... 0000 | 0000 ... 0011 ... 1111 | 1111... 1111... 1111 |

On voit que cette formule isole les 0 de poids faible, ceux situés avant le premier bit à 0, et inverse le tout. Par exemple, le nombre 0110 1100 1111 0000 deviendra : 0000 0000 0000 1111. Ou encore, le nombre 0101 1000 deviendra 0000 0111.

D'autres formules équivalentes peuvent être utilisées. Les voici :

- ;

- .

Isoler le 1 de poids faible et inverser

[modifier | modifier le wikicode]Étudions maintenant ce calcul :

- ;

Le tableau des cas possibles donne ceci :

| XXXX ... XXXX ... XXX1 | XXXX ... X100 ... 0000 | 0000... 0000... 0000 | |

| YYYY ... YYYY ... YYY0 | YYYY ... Y011 ... 1111 | 1111 ... 1111 ... 1111 | |

| XXXX ... XXXX ... XXX0 | XXXX ... X011 ... 1111 | 1111... 1111... 1111 | |

| 1111... 1111... 1110 | 1111 ... 1011 ... 1111 | 1111... 1111... 1111 |

On voit que cette formule isole le 1 de poids faible et inverse le tout. En clair, le résultat est un nombre dont tous les bits sont à 1, sauf à la position du 1 de poids faible dans l'opérande.

Manipuler le ou les bits de poids fort

[modifier | modifier le wikicode]Les opérations précédentes, basées sur un incrément ou un décrément, permettent d'isoler ou de manipuler les 0/1 de poids faible. Mais ils ne peuvent pas toucher aux 0/1 de poids fort. La raison est que la retenue se propage soit jusqu’au zéro de poids faible (incrémentation), soit jusqu'au 1 de poids faible (décrémentation). Manipuler le 1 ou le 0 de poids fort est plus compliqué. Dans ce qui va suivre, nous allons donner un code qui permet d'agir sur les bits qui précédent le 1 de poids fort.

Mettre à 1 les bits situés avant le 1 de poids fort

[modifier | modifier le wikicode]Pour commencer, nous allons voir comment mettre à 1 tous les bits situés avant le 1 de poids fort. Pour donner un exemple, cela permet de transformer 0010 1101 en 0011 1111. Ou encore, cela transforme 0001 0010 en 0001 1111. L'utilité de cette manipulation ne vous parait pas évidente, mais sachez que nous l'utiliserons dans la suite du chapitre.

Pour cela, partons de l’exemple d'un nombre, que l'on va nommer N. Dans ce qui va suivre, ce N vaudra 0010 1101, pour l'exemple. Comme vous le voyez, ce nombre est de la forme 001X XXXX, avec X qui vaut zéro ou 1 selon le bit. Le nombre de la forme immédiatement supérieur lui, vaut 0011 1111. On voit que pour obtenir ce nombre, il faut recopier le 1 le plus à gauche, dans tous les bits à sa droite. Pour cela, quelques décalages font l'affaire.

Pour vous donner une idée, regardons ce que vaut N OU (N >> 1) :

- 001X XXXX OR 0001 XXXX = 0011 XXXX

On voit que le 1 le plus à gauche a été recopié dans le bit à sa droite.

Ensuite, regardons ce que vaut N OU (N >> 1) OU (N >> 2) :

- 001X XXXX OR 0001 XXXX OR 0000 1XXX = 0011 1XXX

Vous commencez à comprendre ? Les bits qui sont à droite du 1 le plus à gauche se remplissent progressivement avec des 1, au fur et à mesure des décalages. Si on pousse le bouchon encore plus loin, on se retrouvera avec un nombre dont tous les bits à droite du 1 le plus à gauche seront tous des 1. Le résultat est un nombre de la forme . Pour être plus précis, il s'agit du nombre de la forme . Il n'y a plus qu'à l'incrémenter pour obtenir la puissance de deux immédiatement supérieure.

On doit donc effectuer suffisamment de décalages pour mettre à 1 tous les bits à droite. On peut croire que pour un nombre de n bits, il faut effectuer n décalages. Mais en réalité, on peut réduire ce nombre assez facilement. Prenons l'exemple du nombre de la forme 1XXX XXXX. On peut effectuer un premier décalage d'un rang vers la droite, ce qui donne : 11XX XXXX. Ensuite, on peut prendre les deux bits à 1 et les recopier dans les deux bits qui suivent. C'est plus rapide que de remplir les bits par un par un. Il faut alors faire un décalage de deux rangs, ce qui donne : 1111 XXXX. Enfin, on peut recopier les 4 bits à 1 dans les 4 bits suivants, ce qui demande un décalage par 4. Si le nombre était plus long, on pourrait réutiliser la même logique : à chaque étape, le nombre de rangs pour le décalage double. Et cela marche pour tous les nombres, peu importe leur écriture binaire. Le code correspondant, bien que spécifique aux nombres de 32 bits, est le suivant :

unsigned SetBitsAfterHighestOne(unsigned n)

{

n |= n >> 1;

n |= n >> 2;

n |= n >> 4;

n |= n >> 8;

n |= n >> 16;

}

Une interprétation mathématique de ce calcul est qu'il donne le nombre de la forme immédiatement supérieur. Par exemple, 5 donnera 7 (8-1), 25 donnera 31 (32-1), 250 donnera 255 (256-1), etc.

Le calcul de la puissance de deux immédiatement supérieure

[modifier | modifier le wikicode]Maintenant que l'on sait calculer le nombre de la forme immédiatement supérieur, on peut facilement deviner comment calculer la puissance de deux immédiatement supérieure à un nombre. Avec un tel calcul, 5 aurait pour résultat 8, 25 donnerait 32, 250 donnerait 256, etc. On pourrait croire qu'il suffirait de prendre le code précédent et d'y ajouter une incrémentation. Dans les faits, ce code ainsi modifié marcherait, mais échouerait dans le cas où le nombre considéré serait lui-même une puissance de deux. Pour éviter cela, il suffit d'ajouter une décrémentation en première instruction.

unsigned NextPowerOf2 (unsigned n)

{

n--;

n |= n >> 1;

n |= n >> 2;

n |= n >> 4;

n |= n >> 8;

n |= n >> 16;

return n++;

}

FFS, FFZ, CTO et CLO

[modifier | modifier le wikicode]Dans cette section, nous allons aborder plusieurs opérations fortement liées entre elles. Dans toutes ces opérations, les bits sont numérotés, leur numéro étant appelé leur position ou leur indice. La première opération, Find First Set, donne la position du 1 de poids faible. Cette opération est liée à l'opération Count Trailing Zeros, qui donne le nombre de zéros situés à droite de ce 1 de poids faible. L'opération Find First Set est opposée au calcul du Find highest set, qui donne la position du 1 de poids fort. Le nombre de zéros situés à gauche de ce bit à 1 est appelé le Count Leading Zeros.